LLM

2025年 10月 15日

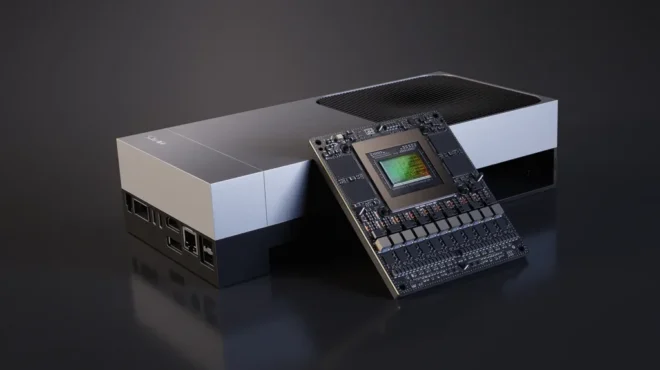

通过 NVIDIA Jetson AGX Thor 实现 7 倍生成式 AI 性能,解锁更快速、更智能的边缘模型

NVIDIA 软件生态系统的一大显著优势在于其持续优化的承诺。今年 8 月,NVIDIA 发布了 Jetson AGX Thor,

2 MIN READ

2025年 10月 13日

使用 NVIDIA Dynamo 部署 72B 模型提升 PD 分离性能

在生产环境部署大模型推理服务时,技术团队往往会遇到诸多挑战,例如缺乏成熟的 PD 分离方案、自动扩缩容机制不够灵活、缺乏动态路由,

2 MIN READ

2025年 10月 11日

探索在大模型训练中使用 Megatron-Core 训练框架提高显存使用效率

在大模型训练中,显存(GPU Memory)始终是最稀缺的资源之一。随着模型规模迈入百亿、千亿甚至万亿参数级别,如何在有限显存中“塞下”…

3 MIN READ

2025年 10月 10日

使用 NVIDIA Nemotron 构建日志分析多智能体自校正 RAG 系统

日志是现代系统的核心所在。然而,随着应用规模不断扩大,日志往往演变成一片冗长繁杂的文本海洋,充斥着重复与冗余信息,令人不堪重负。

2 MIN READ

2025年 10月 9日

从助手到对手:利用代理式 AI 开发者工具

越来越多的开发者开始采用支持人工智能的编码工具,例如 Cursor、OpenAI Codex、Claude Code 和 GitHub…

3 MIN READ

2025年 10月 7日

使用 NVIDIA TensorRT Model Optimizer 剪枝和蒸 LLM

大语言模型(LLM)在自然语言处理(NLP)任务,如代码生成、推理和数学计算等方面,展现出卓越的性能,树立了新的标杆。然而,

3 MIN READ

2025年 9月 29日

利用 NVIDIA Run:ai 和 NVIDIA Dynamo 进行快速高效 LLM 推理的智能多节点调度

大语言模型的复杂性呈指数级增长,带来了诸多挑战,例如模型规模超出单个 GPU 的承载能力、对高吞吐量与低延迟工作负载的需求,

3 MIN READ

2025年 9月 23日

使用 NVIDIA Nemotron 构建检索增强生成 (RAG) 智能体

与基于 LLM 的传统系统受限于其训练数据不同,检索增强生成 (RAG) 通过整合相关的外部信息来提升文本生成效果。

5 MIN READ

2025年 9月 23日

借助生成式 AI 通过分子合成途径进行推理

无论是制药、化学还是材料应用,分子设计中反复出现的挑战在于构建可合成的分子。合成性评估通常需要绘制分子的合成路径:

2 MIN READ

2025年 9月 18日

如何使用 NVIDIA Dynamo 减少 KV 缓存瓶颈

随着 AI 模型变得更大、更复杂,推理,即模型生成响应的过程,正成为一项重大挑战。像 GPT-OSS 和 DeepSeek-R1…

4 MIN READ

2025年 9月 16日

利用 NVIDIA Run:ai 模型流技术降低大型语言模型推理的冷启动延迟

部署大语言模型(LLM)在优化推理效率方面带来了显著挑战。其中,冷启动延迟——即模型加载到 GPU 显存所需的时间较长…

5 MIN READ

2025年 9月 11日

量化感知训练如何实现低精度恢复

训练 AI 模型后,可采用多种压缩技术来优化模型的部署。其中较为常见的是后训练量化(PTQ),该方法通过数值缩放技术,

3 MIN READ

2025年 9月 11日

使用 AI 击杀链框架对 AI 驱动应用进行攻击建模

AI 赋能的应用带来了传统安全模型难以全面覆盖的新攻击面,尤其是当这些代理式系统具备自主性时。应对持续演变的攻击面,其核心原则十分明确:

2 MIN READ

2025年 9月 10日

使用 NVIDIA NIM Operator 3.0.0 部署可扩展的 AI 推理

AI 模型、推理引擎后端以及分布式推理框架在架构、复杂性和规模上持续演进。面对快速的技术变革,

3 MIN READ

2025年 9月 9日

NVIDIA Rubin CPX 加速百万级以上 token 上下文工作负载的推理性能和效率

推理正成为人工智能复杂性的前沿领域。现代模型正逐步演变为具备多步推理能力、持久化记忆和长时程上下文理解的代理式系统,使其能够胜任软件开发、

2 MIN READ

2025年 9月 9日

如何利用跨区域 (Scale-Across) 网络将分布式数据中心连接成大型 AI 工厂

AI 技术日益复杂,训练与推理领域的新进展对数据中心提出了更高的要求。尽管数据中心的功能正在迅速扩展,但其基础设施受限于基本的物理条件,

1 MIN READ