Inference Performance

2025年 9月 29日

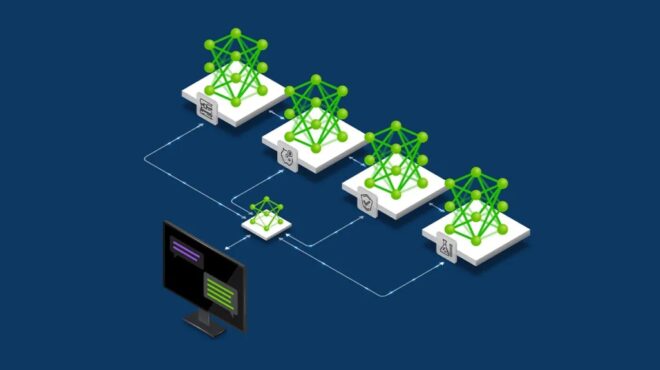

利用 NVIDIA Run:ai 和 NVIDIA Dynamo 进行快速高效 LLM 推理的智能多节点调度

大语言模型的复杂性呈指数级增长,带来了诸多挑战,例如模型规模超出单个 GPU 的承载能力、对高吞吐量与低延迟工作负载的需求,

3 MIN READ

2025年 9月 18日

如何使用 NVIDIA Dynamo 减少 KV 缓存瓶颈

随着 AI 模型变得更大、更复杂,推理,即模型生成响应的过程,正成为一项重大挑战。像 GPT-OSS 和 DeepSeek-R1…

4 MIN READ

2025年 9月 17日

用于降低 AI 推理延迟的预测性解码简介

使用大语言模型(LLM)生成文本时,通常会面临一个基本瓶颈。尽管 GPU 能够提供强大的计算能力,但由于自回归生成本质上是顺序进行的,

2 MIN READ

2025年 9月 16日

利用 NVIDIA Run:ai 模型流技术降低大型语言模型推理的冷启动延迟

部署大语言模型(LLM)在优化推理效率方面带来了显著挑战。其中,冷启动延迟——即模型加载到 GPU 显存所需的时间较长…

5 MIN READ

2025年 9月 10日

使用 NVIDIA NIM Operator 3.0.0 部署可扩展的 AI 推理

AI 模型、推理引擎后端以及分布式推理框架在架构、复杂性和规模上持续演进。面对快速的技术变革,

3 MIN READ

2025年 9月 10日

借助 NVIDIA RTX PRO Blackwell 服务器版本,将蛋白质结构推理速度提高 100 多倍

了解蛋白质结构的研究比以往任何时候都更加重要。从加快药物研发到为未来可能的疫情做好准备,

2 MIN READ

2025年 9月 9日

NVIDIA Rubin CPX 加速百万级以上 token 上下文工作负载的推理性能和效率

推理正成为人工智能复杂性的前沿领域。现代模型正逐步演变为具备多步推理能力、持久化记忆和长时程上下文理解的代理式系统,使其能够胜任软件开发、

2 MIN READ

2025年 8月 25日

NVFP4 实现 16 位训练精度,4 位训练速度和效率

近年来,AI工作负载呈指数级增长,这不仅体现在大型语言模型(LLM)的广泛部署上,也反映在预训练和后训练阶段对处理更多token的迫切需求。

2 MIN READ

2025年 8月 22日

揭秘 NVIDIA Blackwell Ultra:推动 AI 工厂时代的芯片动力

作为 NVIDIA Blackwell 架构系列的最新成员,NVIDIA Blackwell Ultra GPU 依托核心创新,

5 MIN READ

2025年 8月 21日

借助 NVIDIA NVLink 和 NVLink Fusion 扩展 AI 推理性能和灵活性

AI 模型复杂性的指数级增长驱动参数规模从数百万迅速扩展到数万亿,对计算资源提出了前所未有的需求,必须依赖大规模 GPU 集群才能满足。

2 MIN READ

2025年 8月 13日

Dynamo 0.4 最新版本提供高达 4 倍性能提升、基于 SLO 自动扩展和实时可观察性

近期,OpenAI 的 gpt-oss、月之暗面的 Kimi K2 等多个新的前沿开源模型相继问世,标志着大语言模型 (LLM)…

2 MIN READ

2025年 8月 5日

NVIDIA 从云到边缘加速 OpenAI gpt-oss 模型部署,在 NVIDIA GB200 NVL72 上实现 150 万 TPS 推理

自 2016 年推出 NVIDIA DGX 以来,NVIDIA 与 OpenAI 便开始共同推动 AI 技术的边界。

1 MIN READ

2025年 7月 29日

使用全新 NVIDIA Llama Nemotron Super v1.5 构建更加准确、高效的 AI 智能体

AI 智能体现在已经能够解决多步骤问题、编写生产级代码并在多个领域担任通用助手。但要充分发挥其潜力,

1 MIN READ

2025年 7月 14日

借助 NCCL 2.27 实现快速推理和弹性训练

随着 AI 工作负载的扩展,快速可靠的 GPU 通信变得至关重要,这不仅适用于训练,而且越来越适用于大规模推理。

3 MIN READ

2025年 7月 7日

LLM 推理基准测试:使用 TensorRT-LLM 进行性能调优

这是大语言模型延迟 – 吞吐量基准测试系列的第三篇博文,旨在指导开发者如何使用 TensorRT-LLM 对 LLM 推理进行基准测试。

3 MIN READ

2025年 7月 7日

提出一个维基百科规模的问题:如何利用数百万 token 的实时推理使世界更加智能

现代 AI 应用越来越依赖于将庞大的参数数量与数百万个令牌的上下文窗口相结合的模型。无论是经过数月对话的 AI 智能体、

3 MIN READ