云服务

2025年 10月 14日

硬件一致性平台上的内存管理深入剖析

如果您是应用程序开发者或集群管理员,可能已经意识到非统一内存访问(NUMA)会对系统性能产生显著影响。

2 MIN READ

2025年 10月 6日

GPU 原生 Velox 和 NVIDIA cuDF 加速大规模数据分析

随着工作负载规模的扩大以及对高效数据处理需求的提升,相比基于 CPU 的系统,采用 GPU 加速的数据库和查询引擎在性价比方面展现出显著优势。

2 MIN READ

2025年 9月 17日

用于降低 AI 推理延迟的预测性解码简介

使用大语言模型(LLM)生成文本时,通常会面临一个基本瓶颈。尽管 GPU 能够提供强大的计算能力,但由于自回归生成本质上是顺序进行的,

2 MIN READ

2025年 9月 16日

适用于 Python GPU 加速视频处理的 PyNvVideoCodec 2.0 新增功能

Python 中的硬件加速视频处理变得更加便捷。 PyNvVideoCodec 是一个基于 NVIDIA Python 的库,

1 MIN READ

2025年 9月 9日

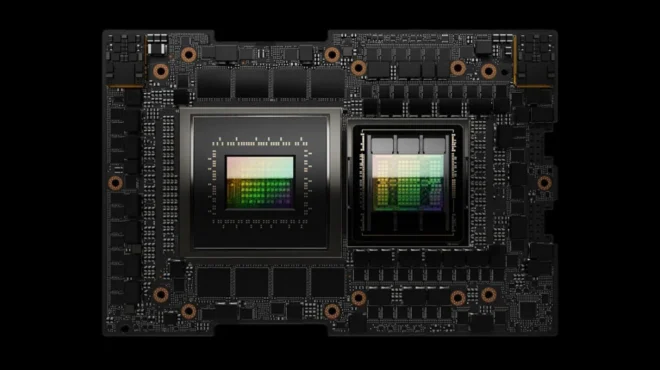

NVIDIA Rubin CPX 加速百万级以上 token 上下文工作负载的推理性能和效率

推理正成为人工智能复杂性的前沿领域。现代模型正逐步演变为具备多步推理能力、持久化记忆和长时程上下文理解的代理式系统,使其能够胜任软件开发、

2 MIN READ

2025年 9月 8日

如何使用 Outerbound 和 DGX 云 Lepton 自行构建 AI 系统

我们往往容易低估实际生产级 AI 系统所涉及的组件复杂性。无论是构建融合内部数据与外部大语言模型的智能体,还是提供按需生成动画的服务,

3 MIN READ

2025年 9月 2日

降低模型部署成本,同时通过 GPU 显存交换保持性能

大规模部署大语言模型(LLM)面临双重挑战:一方面需保障高需求时段的快速响应能力,另一方面又要有效控制 GPU 成本。组织通常面临两难选择:

2 MIN READ

2025年 8月 29日

小型语言模型如何成为可扩展代理人工智能的关键

代理式 AI 的迅速崛起,正在重塑企业、开发者以及整个行业对自动化与数字生产力的认知。从软件开发流程到企业级任务编排,

2 MIN READ

2025年 8月 25日

NVFP4 实现 16 位训练精度,4 位训练速度和效率

近年来,AI工作负载呈指数级增长,这不仅体现在大型语言模型(LLM)的广泛部署上,也反映在预训练和后训练阶段对处理更多token的迫切需求。

2 MIN READ

2025年 8月 1日

通过训练后量化优化 LLM 的性能和准确性

量化是开发者的核心工具,旨在以最小的开销来提高推理性能。通过以可控的方式降低模型精度,无需重新训练,该技术可显著降低延迟、

4 MIN READ

2025年 7月 15日

借助亚马逊云科技上的 NVIDIA Run:ai 加速 AI 模型编排

在开发和部署高级 AI 模型时,访问可扩展的高效 GPU 基础设施至关重要。但是,在云原生、容器化环境中管理此基础设施可能既复杂又昂贵。

1 MIN READ

2025年 7月 14日

借助 NCCL 2.27 实现快速推理和弹性训练

随着 AI 工作负载的扩展,快速可靠的 GPU 通信变得至关重要,这不仅适用于训练,而且越来越适用于大规模推理。

3 MIN READ

2025年 7月 7日

LLM 推理基准测试:使用 TensorRT-LLM 进行性能调优

这是大语言模型延迟 – 吞吐量基准测试系列的第三篇博文,旨在指导开发者如何使用 TensorRT-LLM 对 LLM 推理进行基准测试。

3 MIN READ

2025年 7月 7日

使用 DPU 加速的 Kubernetes 服务代理增强 AI 工厂

随着 AI 借助代理式 AI 向规划、研究和推理发展,工作流变得越来越复杂。为了高效部署代理式 AI 应用,AI 云需要软件定义、

2 MIN READ

2025年 7月 7日

提出一个维基百科规模的问题:如何利用数百万 token 的实时推理使世界更加智能

现代 AI 应用越来越依赖于将庞大的参数数量与数百万个令牌的上下文窗口相结合的模型。无论是经过数月对话的 AI 智能体、

3 MIN READ

2025年 6月 25日

NVIDIA DOCA 3.0 助力 AI 平台开启网络新纪元

NVIDIA DOCA 框架已发展成为新一代 AI 基础设施的重要组成部分。从初始版本到备受期待的 NVIDIA DOCA 3.0 发布,

3 MIN READ