最佳实践

2025年 10月 14日

硬件一致性平台上的内存管理深入剖析

如果您是应用程序开发者或集群管理员,可能已经意识到非统一内存访问(NUMA)会对系统性能产生显著影响。

2 MIN READ

2025年 10月 8日

训练联合 AI 模型以预测蛋白质属性

预测蛋白质在细胞内的定位对于生物学研究和药物开发具有重要意义,这一过程被称为亚细胞定位。蛋白质的功能与其所处位置密切相关,明确其存在于细胞核、

2 MIN READ

2025年 10月 6日

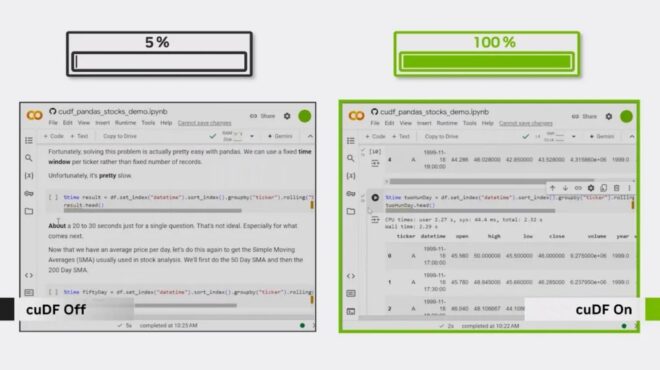

GPU 原生 Velox 和 NVIDIA cuDF 加速大规模数据分析

随着工作负载规模的扩大以及对高效数据处理需求的提升,相比基于 CPU 的系统,采用 GPU 加速的数据库和查询引擎在性价比方面展现出显著优势。

2 MIN READ

2025年 9月 18日

如何使用 NVIDIA Dynamo 减少 KV 缓存瓶颈

随着 AI 模型变得更大、更复杂,推理,即模型生成响应的过程,正成为一项重大挑战。像 GPT-OSS 和 DeepSeek-R1…

4 MIN READ

2025年 9月 11日

使用 AI 击杀链框架对 AI 驱动应用进行攻击建模

AI 赋能的应用带来了传统安全模型难以全面覆盖的新攻击面,尤其是当这些代理式系统具备自主性时。应对持续演变的攻击面,其核心原则十分明确:

2 MIN READ

2025年 9月 10日

使用 NVIDIA NIM Operator 3.0.0 部署可扩展的 AI 推理

AI 模型、推理引擎后端以及分布式推理框架在架构、复杂性和规模上持续演进。面对快速的技术变革,

3 MIN READ

2025年 9月 9日

如何利用跨区域 (Scale-Across) 网络将分布式数据中心连接成大型 AI 工厂

AI 技术日益复杂,训练与推理领域的新进展对数据中心提出了更高的要求。尽管数据中心的功能正在迅速扩展,但其基础设施受限于基本的物理条件,

1 MIN READ

2025年 9月 8日

如何使用 Outerbound 和 DGX 云 Lepton 自行构建 AI 系统

我们往往容易低估实际生产级 AI 系统所涉及的组件复杂性。无论是构建融合内部数据与外部大语言模型的智能体,还是提供按需生成动画的服务,

3 MIN READ

2025年 9月 2日

借助启发式算法和 CUTLASS 4.2 提高 NVIDIA GPU 上的 GEMM 内核自动调整效率

为特定问题和硬件选择合适的通用矩阵乘法(GEMM)核函数是一项重大挑战。GEMM 核函数的性能由一系列编译时和运行时的元参数共同决定,

2 MIN READ

2025年 8月 27日

如何通过共享内存寄存器溢出来提高 CUDA 内核性能

当 CUDA 内核所需的硬件寄存器数量超过可用数量时,编译器会将多余的变量溢出到本地内存中,这一过程称为寄存器溢出。

3 MIN READ

2025年 8月 13日

利用 Wheel Variants 简化 CUDA 加速 Python 的安装和打包工作流程

如果您曾经安装过 NVIDIA GPU 加速的 Python 软件包,您可能遇到过这样的场景:导航到 pytorch.org、jax.dev、

4 MIN READ

2025年 7月 29日

使用 NVIDIA Omniverse 构建 CAD 到 USD 工作流

在应用程序之间传输 3D 数据一直是一项挑战,尤其是原生计算机辅助设计 (CAD) 文件等专有格式。

5 MIN READ

2025年 7月 24日

借助 NVIDIA cuVS 优化索引和实时检索的向量搜索

AI 赋能的搜索需要高性能索引、低延迟检索和无缝可扩展性。NVIDIA cuVS 为开发者和数据科学家带来了 GPU…

2 MIN READ

2025年 7月 18日

3 个 pandas 工作流在大型数据集上严重变慢,直到启用了 GPU 加速

如果您使用 pandas,您可能已经撞到了墙壁。正是在这个时刻,您值得信赖的工作流程在处理较小的数据集时表现出色,在处理大型数据集时陷入停顿。

1 MIN READ

2025年 7月 10日

借助 GliaCloud 和 NVIDIA Omniverse 库加速视频制作和定制

生成式 AI 视频模型的激增以及这些模型引入的新工作流程,显著提高了创意和营销技术行业的生产效率,并提高了输出质量。

1 MIN READ

2025年 7月 9日

使用 NVIDIA NeMo-RL 进行强化学习:通过 GRPO 复制 DeepScaleR 配方

强化学习 (RL) 是交互式 AI 的支柱。它对于教导智能体推理和从人类偏好中学习、实现多轮工具使用等至关重要。

2 MIN READ