NVIDIA MERLIN

NVIDIA Merlin™ é um framework de código aberto para a construção de sistemas de recomendação de deep learning em grande escala.

Projetado para Workflows de Recomendação

O Merlin capacita cientistas de dados, engenheiros de machine learning e pesquisadores a criar recomendações de alto desempenho em escala. O Merlin inclui bibliotecas, métodos e ferramentas que democratizam a construção de recomendações de deep learning, abordando os desafios comuns de pré-processamento, engenharia de recursos, treinamento e inferência. Cada componente do pipeline de Merlin é otimizado para suportar centenas de terabytes de dados, todos acessíveis por meio de APIs fáceis de usar. Com o Merlin, previsões melhores do que os métodos tradicionais e taxas de cliques aumentadas estão ao nosso alcance.

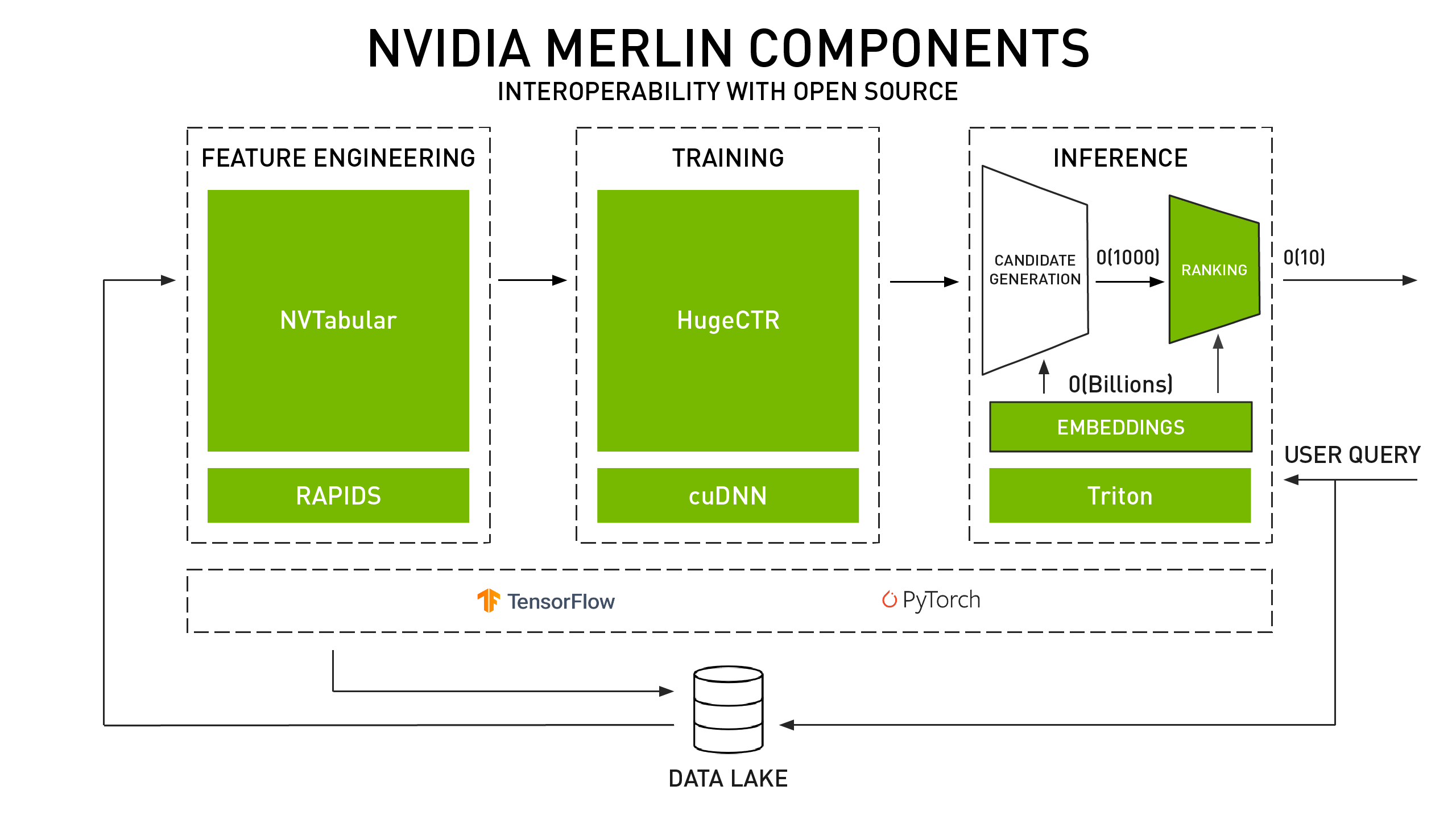

Uma Arquitetura Referencial De Ponta-a-Ponta

NVIDIA Merlin acelera todo o pipeline, desde a ingestão e o treinamento até a implantação de sistemas de recomendação acelerados por GPU. Os componentes de código aberto do Merlin simplificam a construção e implantação de um pipeline de qualidade de produção.

NVTabular

Merlin NVTabular é uma biblioteca de pré-processamento e engenharia de recursos projetada para manipular terabytes de conjuntos de dados do sistema de recomendação e reduzir significativamente o tempo de preparação de dados.

HugeCTR

Merlin HugeCTR é um framework de treinamento de rede neural profunda projetada para sistemas de recomendação. Ele fornece treinamento distribuído com tabelas de incorporação de modelos paralelos e redes neurais paralelas de dados em várias GPUs e nós para desempenho máximo.

Experimente hoje:

TensorRT e Triton

Aproveite as vantagens do Servidor de Inferência NVIDIA Triton™ e do NVIDIA® TensorRT™ para executar a inferência com eficiência em GPUs, maximizando a taxa de transferência com a combinação certa de latência e utilização de GPU.

Experimente hoje:

Recursos

Acelere os Recomendadores em GPUs NVIDIA

Aprenda sobre o pipeline de treinamento do sistema de recomendação, as vantagens técnicas do NVTabular, resultados de benchmarking e como começar.

Kit de Recursos Técnicos Merlin

Aprenda como acelerar todo o pipeline, desde a ingestão e o treinamento até a implantação de sistemas de recomendação acelerados por GPU.

NVIDIA Deep Learning Institute (DLI)

Inscreva-se neste workshop DLI para aprender sobre as ferramentas e técnicas fundamentais para construir sistemas de recomendação altamente eficazes.

Aplicações de Referência Merlin

Comece com implementações de referência de código aberto e obtenha precisão de última geração em conjuntos de dados públicos com até 10 vezes a aceleração.

AMPLO E PROFUNDO NO TENSORFLOW

Responda a esta pesquisa para compartilhar algumas informações sobre o pipeline de recomendação e influenciar o roteiro do NVIDIA Merlin.