像 COVID-19 流行病期间的许多学校和大学一样,比萨大学,意大利最古老的大学之一,面临着寻找解决问题的解决方案的挑战,而许多学生不得不远程上课。

该大学的研究计算系重点研究人工智能深度学习和机器学习应用,他们通常在本地使用裸机系统执行计算。这种类型的实施通常与运行传统应用程序的虚拟化基础设施分开,这也是学生和教员所需的,从而创建了一个筒仓式环境,导致管理挑战和复杂性。

在流感大流行期间,他们是新 NVIDIA AI 企业软件套件的早期访问用户,该套件针对 VMware vSphere 环境进行了优化,并提供了与裸机系统类似的计算性能。

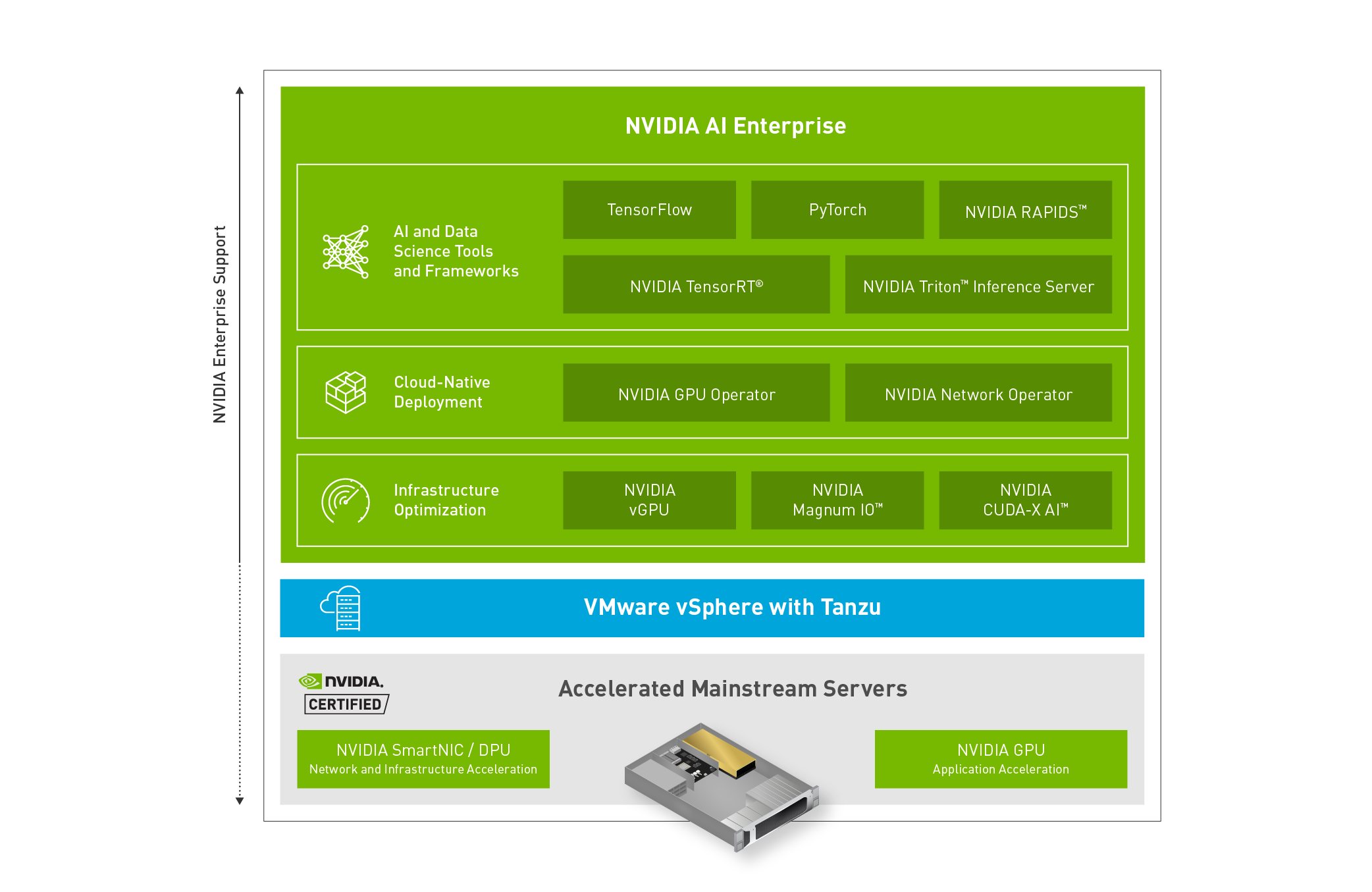

NVIDIA AI Enterprise 是一套端到端、云本机的 AI 软件,经 VMware vSphere 7 Update 2 或更高版本认证,并经过 NVIDIA 认证的加速主流服务器,如 Dell EMC PowerEdge 。 NVIDIA AI Enterprise 软件套件包括 NVIDIA 的关键启用技术和软件,用于快速部署、管理、,以及虚拟化数据中心中 AI 工作负载的扩展。 NVIDIA AI Enterprise 由 NVIDIA 认证、许可和支持。

Maurizio Davini ,比萨大学的 CTO 和 Davide Bacciu 教授的团队都知道他们的校内基础设施不仅满足了学校中许多群体的计算需要,而且有一个有经验的 IT 支持系统。

为了建立一个可扩展且更易于管理的环境,以便更好地与现有基础架构集成,该大学希望 NVIDIA AI Enterprise 能够在 VMware vSphere 上运行,并配备经 NVIDIA 认证的 Dell EMC VxRail Hyperconvered 服务器。首先,该大学需要评估虚拟化人工智能基础设施是否能够抵抗本地裸机系统提供的性能。

虚拟化环境中的裸机性能

为了进行“苹果对苹果”的比较, CTO Davini 的裸机设置在安装了 NVIDIA DGX 操作系统的 Dell EMC PowerEdge XE8545 服务器中使用了单个 NVIDIA A100 Tensor Core GPU 。对于虚拟化环境, NVIDIA A100 GPU 和 NVIDIA BlueField 数据处理单元( DPU s )安装在带有 VMware vSphere 和 NVIDIA AI 企业软件套件的 Dell EMC VxRail 服务器中。然后,研究计算部门执行两个 AI 工作负载,涉及特定生物数据的图形,另一个使用 MIDI 文件生成音乐。

作为 CLAIRE-COVID-19 生物信息学小组的协调员, CTO Davini 和 Bacciu 教授的团队利用手头的数据,对由蛋白质、疾病和基因的生物相互作用网络组成的图表进行了深入的学习,将深度学习技术应用于图形是人工智能发展最快的研究课题之一,该技术正在推动符号和亚符号杂交系统在多个应用领域的发展。

每个网络大小都是一个由 6000 多个分子图组成的数据集,超过 45000 个节点和 74000 条边。他们使用 2-3 层和 350 到 700 个单位的隐藏神经元,从图形同构网络借用,结合多层感知器进行分类,训练了 36 种不同的图形网络配置。

该实验是使用 PyDGN 进行的, PyDGN 是 GitHub 上的一个公开可用的 Python 库,专门用于图形神经网络。每个图形神经网络配置都经过 10000 个历元的训练,这是通过机器学习算法完成的整个训练数据集的通过次数。

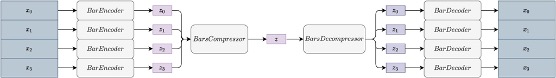

Bacciu 教授的团队还开发了一种基于 transformer 的对抗式自动编码器用于音乐生成,他们称之为 MUSAE2 . 0 。基于 transformer 的深度学习使用注意算法,这是一种衡量数据集中变量之间关系并对其进行优先级排序的方法。传统上,它用于自然语言处理领域,试图在一组输入数据中识别单词或声音的上下文,以便预测和生成所需的输出。

该团队的模型使用了 256 个值的嵌入大小,其中嵌入使用的是数据,在本例中是歌曲,并将它们表示为矢量数字,以便可以通过机器学习算法进行计算。每层由 512 个隐藏神经元组成,共有四个注意头,这是一组矩阵,显示数据之间关系的计算加权注意。

他的团队在编码器和解码器中使用了六层,基本上将数据转换为矢量格式,然后将输出转换为所需的音乐格式。巴丘教授的模型使用 Lakh MIDI 数据集进行训练,该数据集包含 100000 个 MIDI 文件。

在图 2 中,是编码为代表性数据的数据输入,

,然后压缩为更小的表示形式,

,其中包括从输入中观察到的相关数据。

然后解压并解码回 MIDI 格式,具有所需的输出功能。

在进行人工智能实验后, CTO Davini 和各个测试团队得出结论, GPU 加速裸机设置和 NVIDIA 人工智能企业 NVIDIA 虚拟化环境之间的性能差异可以忽略不计这些研究结果证明了 GPU 加速的选项可供比萨大学的研究人员和科学家使用。

裸机系统将继续成为学校人工智能研究基础设施的重要组成部分。展望未来,现在通过 NVIDIA 认证的 Dell EMC VxRail 超聚合服务器与使用 NVIDIA AI 企业软件运行工作负载的 VMware vSphere 服务器提供相同的计算性能,但得益于灵活、易于部署和管理的平台。因为 NVIDIA AI 企业使用主流服务器,这些服务器还可以轻松地在其 AI 工作负载的同时运行其他企业应用程序,确保优化利用率,以适应大学的需要。

让所有人都能使用加速人工智能

使用 NVIDIA AI Enterprise 的部门最显著的特点之一是部署计算资源的方便性和速度。通过使用 DeepOps ,部门能够跨工作节点群集自动部署 Kubernetes 。 DeepOps 用于安装必要的 GPU 驱动程序,加载 NVIDIA Docker 容器工具包,以及 GPU 加速工作负载的其他资源。

然后, Kubernetes 用于自动部署、扩展和管理集装箱化应用程序。国防部还利用 NVIDIA NGC 目录,这是一个标准化软件包的存储库,包括 NVIDIA AI 企业套件中包含的容器、预训练模型和 AI SDK ,使必要软件的安装变得容易,并可供任何学生使用。

CTO Davini 和比萨大学计划将其混合的裸金属系统环境和 NVIDIA AI 企业虚拟化环境,包括戴尔的 EMC PrPosixXe85 45 和 VxRoad Server ,放到未来。该部门的重点是传统地执行深度学习和量子计算模拟器的实验,但由于 NVIDIA 认证服务器上的 NVIDIA AI 企业解决方案,他们也看到了高性能计算( HPC )工作负载带来的好处。该解决方案实现了易管理性、可扩展性和性能,比萨大学将这些好处视为继续下一代计算基础设施的关键因素。

有关更多信息,请观看即将举行的使学生、教师和研究人员可以随时随地访问 AI GTC 课程,该课程由该校首席技术官莫里齐奥·达维尼主持。