Megatron

2022年 8月 3日

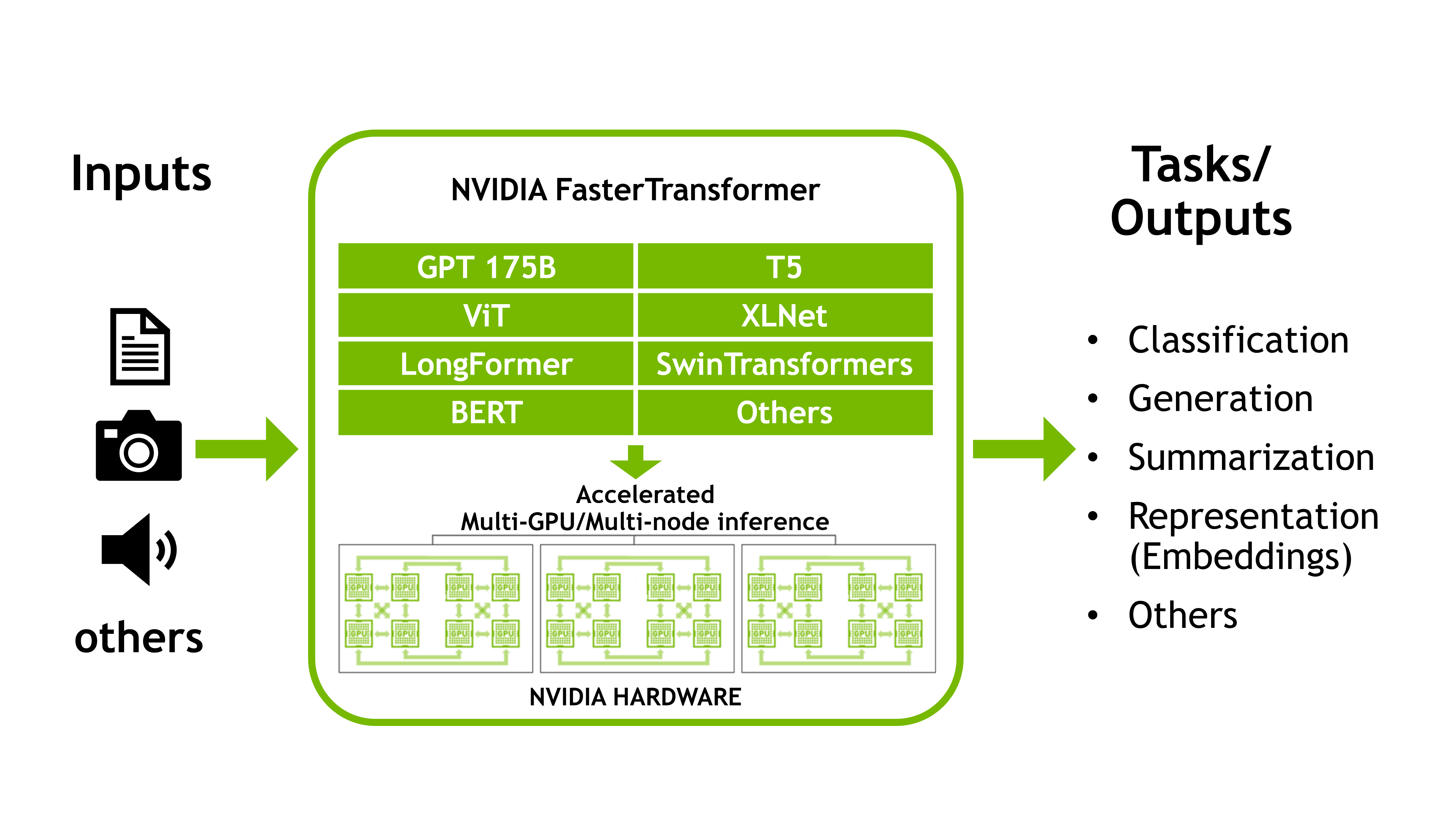

使用 FasterTransformer 和 Triton 推理服务器加速大型 Transformer 模型的推理

这是讨论 NVIDIA FasterTransformer 库的两部分系列的第一部分,

3 MIN READ

2022年 8月 3日

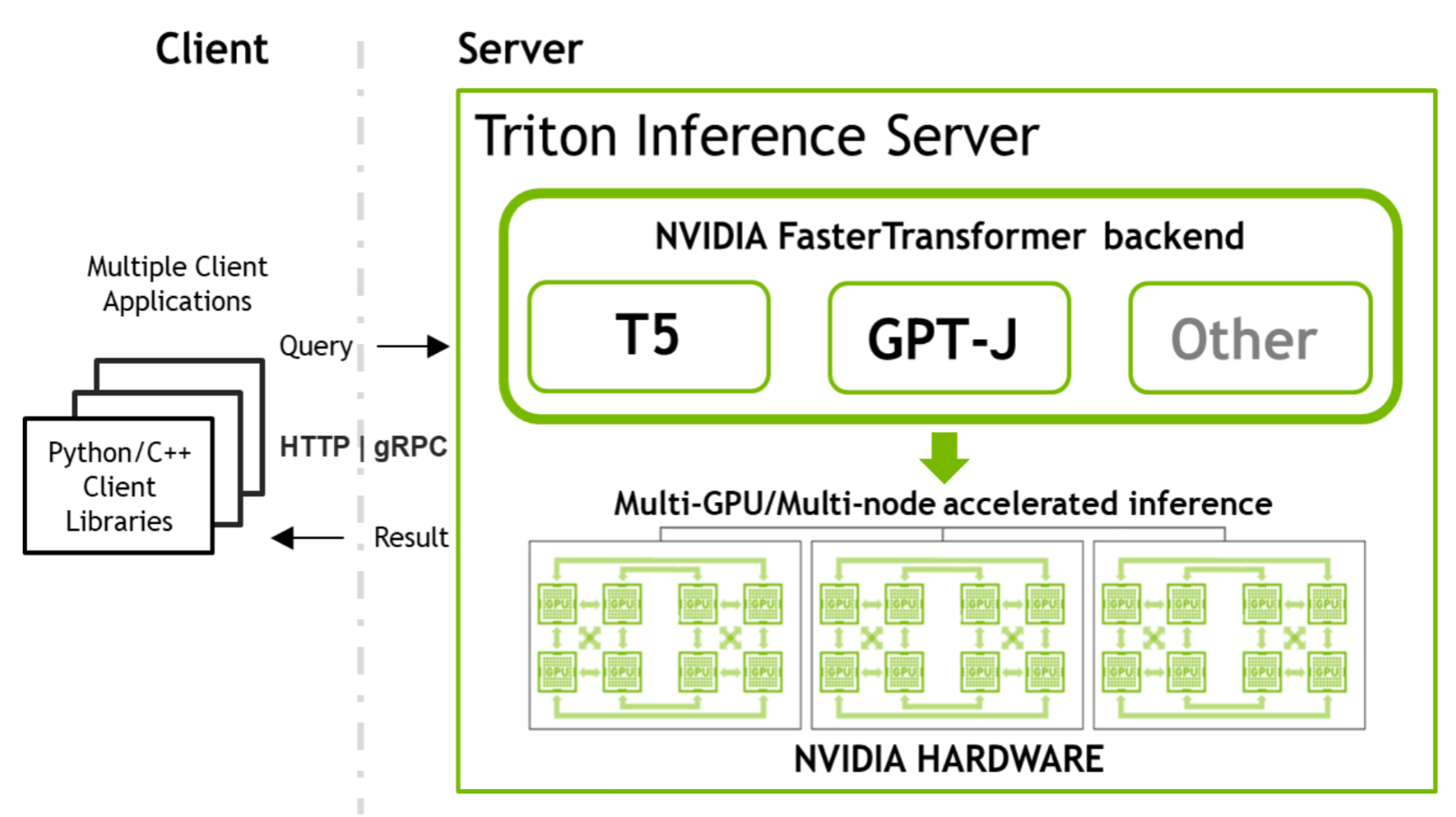

使用 FasterTransformer 和 Triton 推理服务器部署 GPT-J 和 T5

这是关于 NVIDIA 工具的两部分系列的第二部分,这些工具允许您运行大型Transformer模型以加速推理。

5 MIN READ

2022年 7月 12日

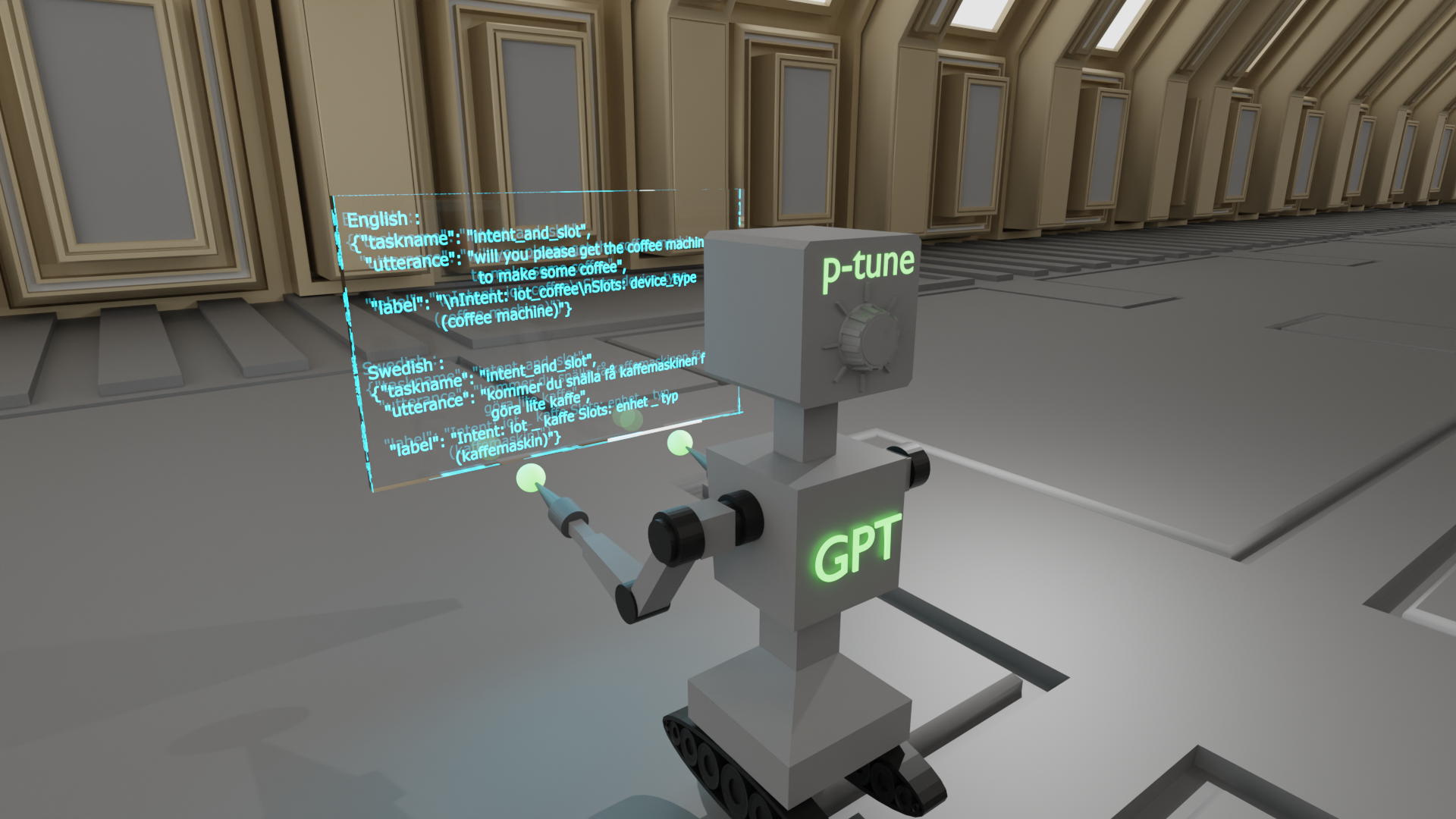

采用 P-Tuning 解决非英语下游任务

随着对预训练大型语言模型( LLM )权重访问需求的增加,围绕 LLM 共享的环境正在发生变化。最近,

3 MIN READ

2022年 5月 12日

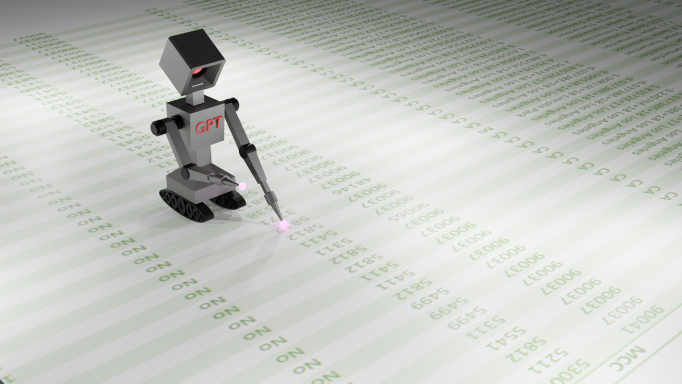

使用 Transformers 生成合成数据:企业数据挑战的解决方案

大数据、新算法和快速计算是使现代 AI 革命成为可能的三个主要因素。然而,数据给企业带来了许多挑战:数据标记困难、数据治理效率低下、

2 MIN READ

2022年 3月 9日

GTC 内幕指南:计算机视觉、 NLP 、推荐者和机器人

寻找不同的主题领域?留意我们的其他帖子! 3 月 21 日至 24 日,加入 GTC ,探索人工智能、计算机视觉、数据科学、

1 MIN READ

2021年 11月 9日

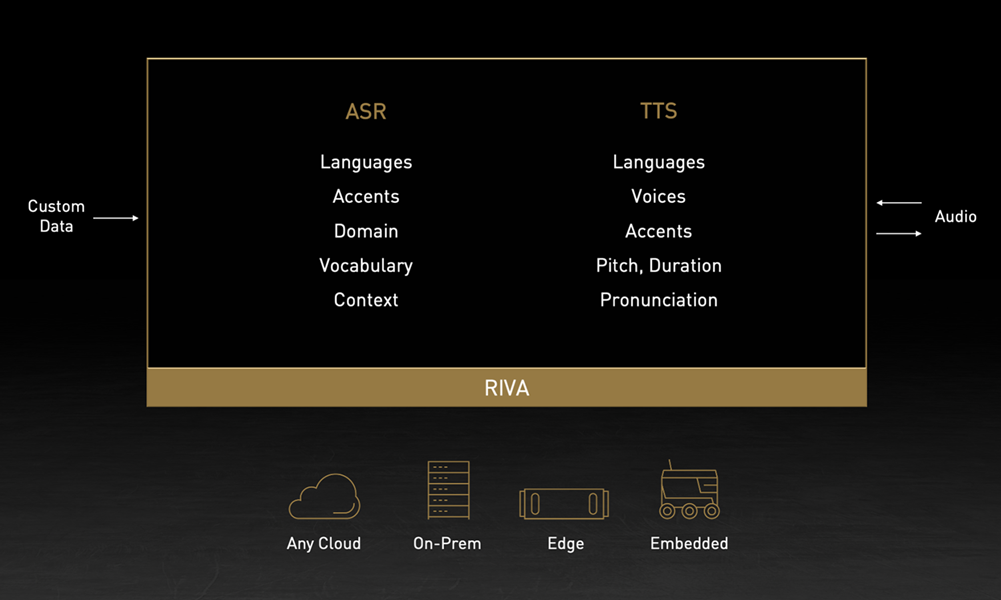

NVIDIA 发布 Riva 语音 AI 和大型企业语言建模软件

NVIDIA 最近发布了 NVIDIA Riva 在语音人工智能方面的新突破, NVIDIA NeMo 在大规模语言建模( LLM…

1 MIN READ

2021年 10月 11日

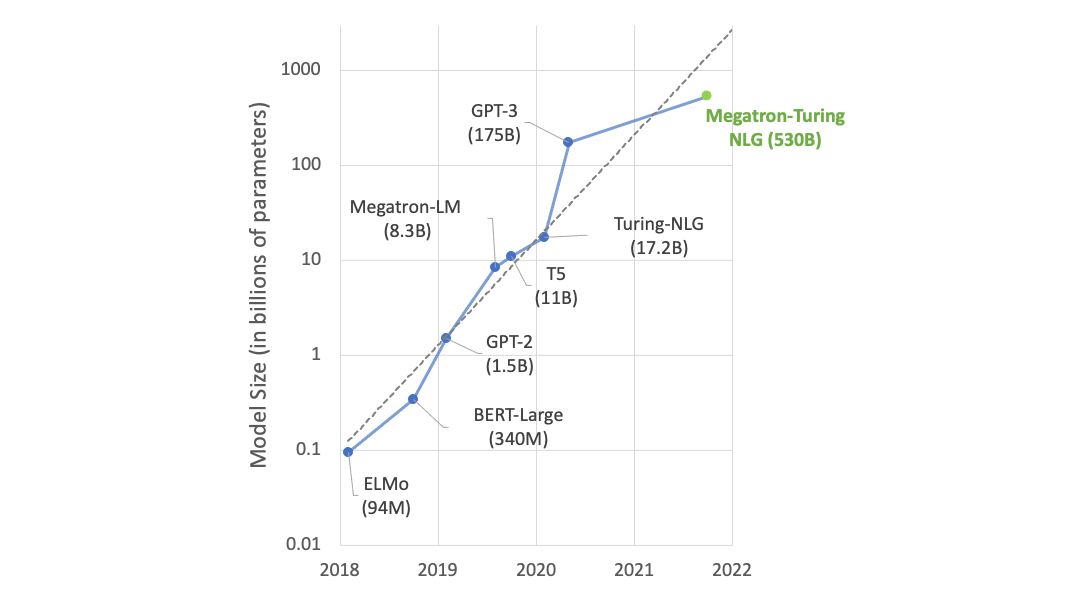

使用 DeepSpeed 和 Megatron 培训 Megatron 图灵 NLG 530B ,世界上最大、最强大的生成性语言模型

我们很高兴地介绍由 DeepSpeed 和 Megatron 驱动的 Megatron 图灵自然语言生成模型( MT-NLG ),

3 MIN READ