智能空间带来了前所未有的价值,在物理世界和数字世界之间创造了持续的信息流。

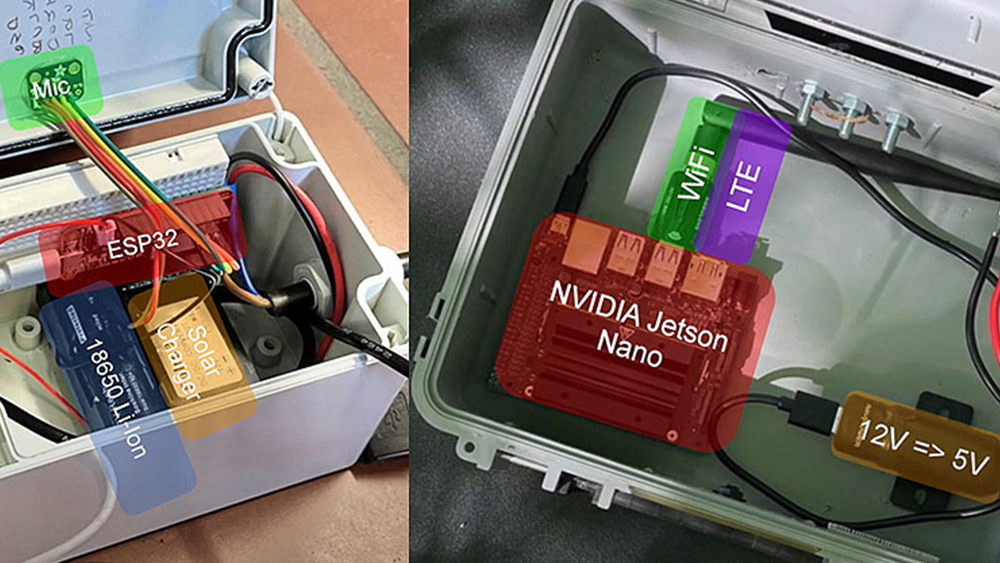

通过将物联网( IoT )、云计算、机器学习和人工智能等技术融入边缘,世界级企业可以捕获数字数据并将其转化为可操作的见解。

然而,由于边缘环境分布在封闭的数据中心范围之外,这一过程非常复杂,需要跨多个位置进行管理。

工业嵌入式闪存和 DRAM 解决方案提供商 Innodisk 试图解决这些问题,同时为其子公司 Aetina 建造智能工厂。与 NVIDIA 密切合作, Innodisk 开始了为工业环境构建高性能端到端视觉 AI 解决方案的任务。

人工智能项目分为两个阶段:人工智能模型开发和人工智能模型部署。本文讨论了与这些步骤相关的常见挑战,以及 Innodisk 如何利用不同的工具和技术来解决这些问题。

开发 AI 模型

该项目从开发一种能够满足严格质量生产标准的产品检验解决方案开始。 Innodisk 生产的闪存和 DRAM 产品是针对恶劣环境和应用而设计的小型复杂组件。

Innodisk 需要一种能够快速处理高分辨率图像识别任务的解决方案,并且在开发边缘 AI 模型时面临克服几个常见问题的挑战。这包括原始数据不足、数据处理时间长、模型训练成本高、计算能力需求高,以及验证模型是否已准备好部署。

Aetina 使用 NVIDIA TAO Toolkit (可通过 NVIDIA AI Enterprise 获得),在短短几天内创建了可用于生产的 AI 模型,以满足 Inndisk 的需求。虽然这通常需要几个月的时间,但他们通过微调 NVIDIA 预训练模型 加快了这一过程,而不是从头开始训练模型。

经过培训,该模型被集成到一个应用程序中。 Aetina 将应用程序容器化,以便在边缘轻松部署。然后,他们将定制的容器上传到他们的私有注册表。

部署 AI 模型

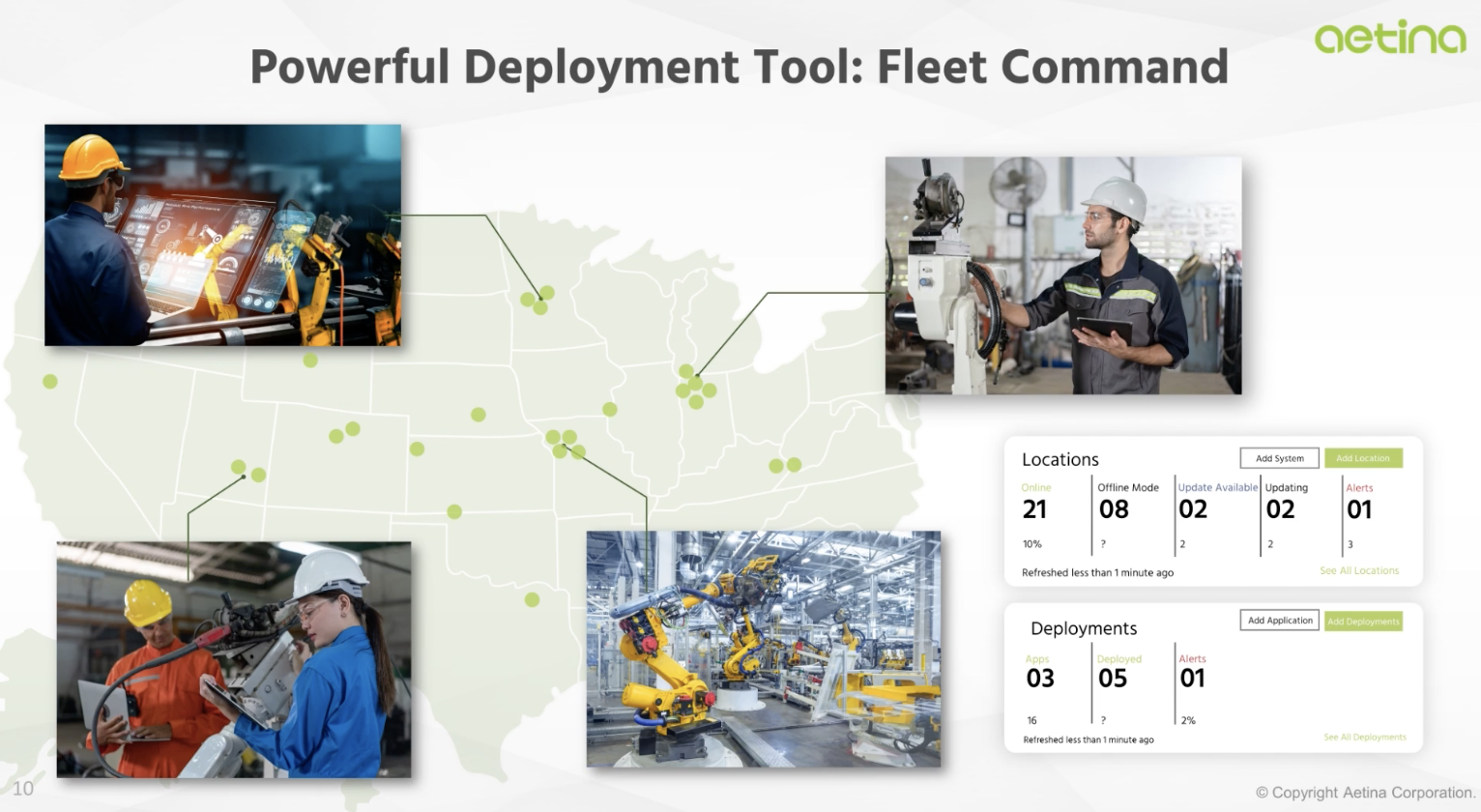

完成应用程序后,下一步是找到大规模部署和管理应用程序的解决方案。

他们转向 cloud-native technology 来管理其边缘部署。在本例中,他们使用了 Kubernetes ,一个用于容器化应用程序的开源系统,创建了舵图来部署他们的应用程序。

凭借 NVIDIA TAO 工具包, Aetina 迅速从模型开发转向部署。但是,模型部署也带来了复杂性。企业通常要解决部署时间长、安全问题以及昂贵的部署和监控成本。

Aetina 希望 NVIDIA Fleet Command 缓解这些问题。

Fleet Command 是一个用于容器编排的托管平台,它简化了边缘系统和 AI 应用程序的供应和部署。应用程序部署后,通过空中应用程序更新、远程监控和管理以及防止泄漏和数据伪造的严格数据保护,简化了 AI 生命周期。

使用 Fleet Command Aetina 快速轻松地部署了其 AI 模型。

完成端到端人工智能工作流

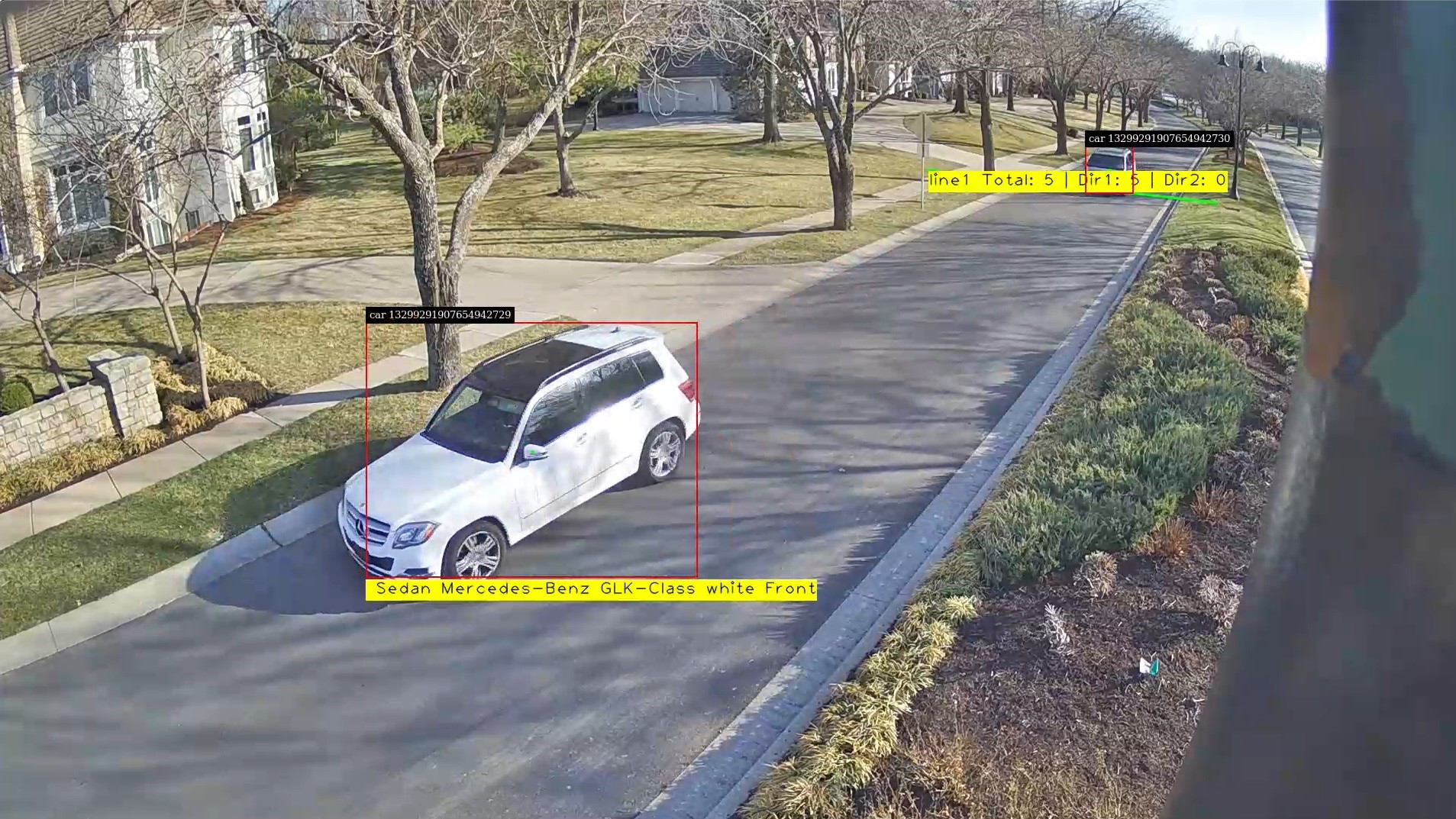

使用这种视觉 AI 解决方案, Innodisk 现在可以在不到 1 秒的时间内进行精确的检查,使他们能够高效、经济地生产更多的产品。

在这之前,工厂依靠一名驻守在工厂生产线上的人类检查员,花 10 秒钟完成同样的任务。通过这种解决方案,工厂工人可以从单调的任务中解脱出来,专注于更重要的功能。

该过程还导致 Aetina 构建了一个端到端解决方案,其他组织可以使用该解决方案将其环境转换为智能空间。

要了解有关此解决方案的更多信息,请查看按需 GTC 会话 End-to-End Smart Factory AI Application: From Model Development to Deployment with Aetina 。