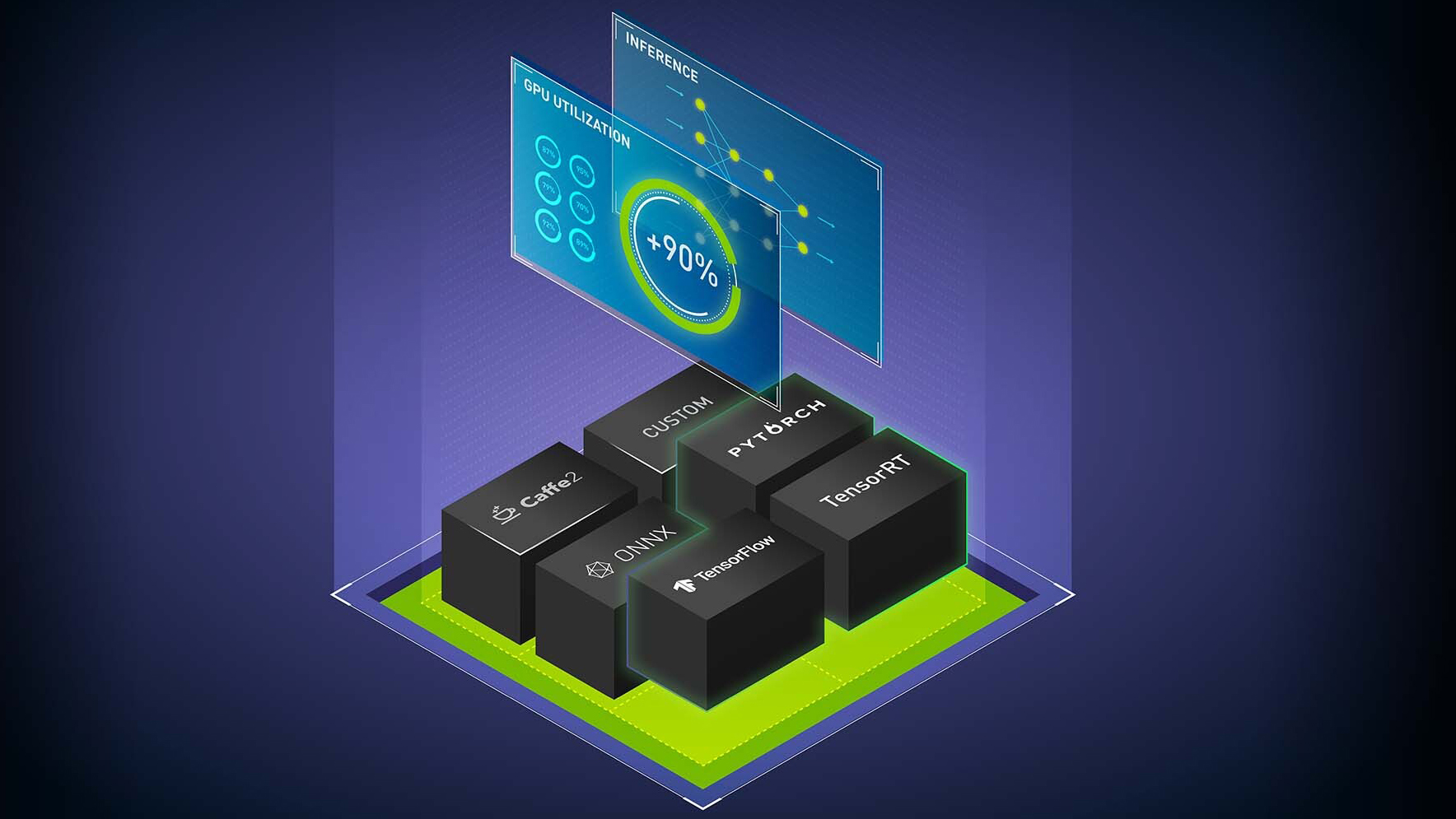

NVIDIA AI 推理软件包括NVIDIA Triton 推理服务器,开源推理服务软件,以及NVIDIA TensorRT,一个用于高性能深度学习推理的 SDK ,包括深度学习推理优化器和运行时。它们为所有人工智能深度学习用例提供加速推理。 NVIDIA Triton 还支持传统的机器学习( ML )模型和 CPU 上的推理。这篇文章解释了该软件最近添加的关键新功能。

NVIDIA Triton

NVIDIA Triton 中的新功能包括 Py Triton 本机 Python 支持、模型分析器更新和 NVIDIA Triton 管理服务。

本机 Python 支持 PyTriton

PyTriton 功能提供了一个简单的接口,可以在 Python 代码中使用 NVIDIA Triton InferenceServer 。 Py Triton 使 Python 开发人员能够使用 NVIDIA Triton 来服务从人工智能模型或简单处理功能到整个推理管道的一切。

这种对 GPU 中 NVIDIA Triton 的原生支持使 ML 模型能够以高性能、高效率和高硬件利用率进行快速原型设计和测试。一行代码就可以调出 NVIDIA Triton ,提供了动态批处理、并发模型执行以及 Python 代码中对 GPU 和 Python 的支持等优势。这种方法无需设置模型存储库和转换模型格式。您可以使用现有的推理管道代码而无需修改。要尝试,请访问triton-inference-server/pytriton在 GitHub 上。

模型分析仪

模型分析器是一种帮助找到最佳 NVIDIA Triton 模型配置的工具,如批量大小、模型并发性和精度,以部署高效的推理。由于新的快速搜索模式,您可以在几分钟内获得最佳配置,而无需花费数天时间手动尝试配置参数

现在,除了支持具有预处理和后处理要求的现代推理工作负载的独立模型外,模型分析器还支持模型集成(也称为模型管道)和多模型分析。您可以为整个 ML 管道运行模型分析器。有关详细信息,请参阅模型分析器文档.

NVIDIA Triton 管理服务

NVIDIA Triton 管理服务为高效的多模型推理提供了模型编排功能。此功能作为生产服务运行,可根据需要加载模型,并在不使用时卸载模型

它通过在单个 GPU 服务器上放置尽可能多的模型来有效地分配[Z1K1’资源,并有助于对不同框架中的模型进行优化分组,以实现高效的内存使用。它现在支持基于推理和加密(AES-256)与应用程序通信的高利用率的 NVIDIA Triton 实例的自动缩放。申请提前访问 NVIDIA Triton 管理服务。

NVIDIA TensorRT

TensorRT 中的新功能包括多 GPU 多节点推理、性能和硬件优化等。

多 – GPU 多节点推理

TensorRT 可用于运行大型语言模型( LLM )的多 GPU 多节点推理。它支持 GPT-3 175B 、 530B 和 6.7B 型号。这些型号不需要 ONNX 转换;相反,一个简单的 Python API 可用于优化多 GPU 推理。现在可以私人提前访问。有关更多详细信息,请联系您的 NVIDIA 帐户团队

TensorRT 8.6

TensorRT 8.6 现在可提前访问并且包括以下关键特征:

- 生成人工智能扩散和 transformer 模型的性能优化

- 在不同 GPU 体系结构上构建和运行的硬件兼容性 (NVIDIA Ampere 架构及以后)

- 版本兼容性,可在不同的 TensorRT 版本( TensorRT 8.6 及更高版本)上构建和运行

- 在构建时间和推理性能之间进行权衡的优化级别

客户和合作伙伴亮点

了解以下新客户和合作伙伴如何使用 NVIDIA Triton 和 TensorRT 进行人工智能推理。

Oracle 人工智能 使用 NVIDIA Triton 为 OCI Vision 中基于深度学习的图像分析工作负载提供服务。视觉服务用于各种用例,从制造缺陷检查到在线图像中的标记项目。 Oracle 使用 NVIDIA Triton 实现了 50% 的低延迟和 2 倍的吞吐量。

Uber 利用 NVIDIA Triton 为 DeepETA (该公司基于深度学习的全球 ETA 模型)每秒提供数十万次预测。

Roblox,在线体验平台,使用 NVIDIA Triton 在多个框架中运行所有人工智能模型,以实现游戏推荐、构建头像、内容审核、市场广告和欺诈检测等用例。 NVIDIA Triton 让数据科学家和 ML 工程师可以自由选择他们的框架: TensorFlow 、 PyTorch 、 ONNX 或原始 Python 代码。

Docusign 使用 NVIDIA Triton 运行 NLP 和计算机视觉模型,用于人工智能辅助审查和理解协议和合同条款。与之前基于 CPU 的解决方案相比,该公司实现了 10 倍的加速。

Descript 使用 TensorRT 优化模型以加速人工智能推理。它允许用户在没有演播室的情况下替换视频背景并增强语音,以制作演播室质量的内容。

CoreWeave,专门的 GPU 云提供商使用 NVIDIA Triton 以低延迟和高吞吐量为 LLM 提供服务。

NVIDIA 推理软件提供了关键的性能、效率和响应能力,为云、数据中心、网络边缘和嵌入式设备中的下一代人工智能产品和服务提供动力。从今天开始NVIDIA Triton和TensorRT.