检测可驾驶自由空间是高级驾驶员辅助系统( ADAS )和自动驾驶汽车( AV )感知的关键组成部分。障碍物检测通常用于检测一组特定的动态障碍物,如车辆和行人。

相比之下,自由空间检测是一种更通用的障碍物检测方法。它使自动驾驶汽车能够安全地绕过许多类型的障碍物,如树木或路缘石,即使没有经过明确的训练来识别特定的障碍物类别。

传统上,摄像机系统已经被用来解决这一任务。然而,在恶劣的天气和弱光条件下,或者在识别距离车辆更远的物体时,摄像头的感知性能可能会受到影响。为了克服这些挑战,我们开发了一种使用雷达的自由空间探测系统。它在应对天气和照明挑战方面非常强大,并且能够直接测量距离。

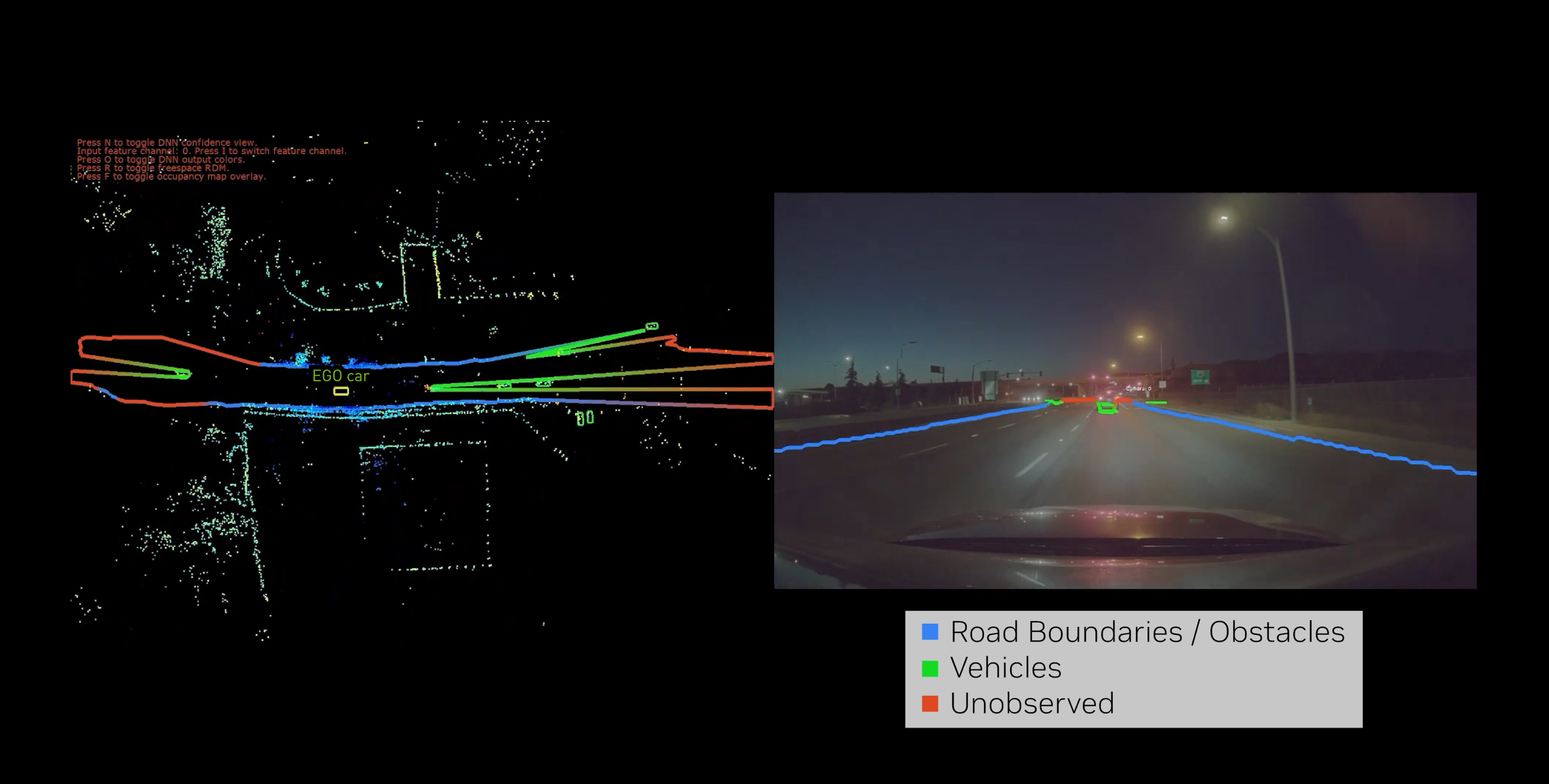

我们的系统作为 ADAS 和 AV 感知的一部分工作,以检测可驾驶的自由空间,并在多传感器融合过程中进一步改善 3D 感知。更具体地说, RadarNet 是一种深度神经网络( DNN ),它使用汽车雷达传感器检测动态障碍物和可驾驶的自由空间。有关更多详细信息,请参见 NVRadarNet: Real-Time Radar Obstacle and Free Space Detection for Autonomous Driving 。

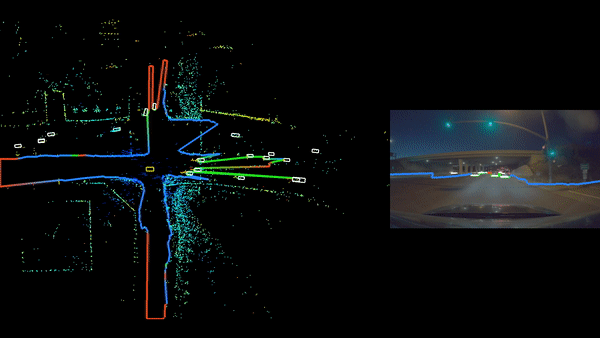

在下面的 NVIDIA DRIVE Dispatch 视频中观看 RadarNet 深度神经网络的运行示例。

视频 1 。观看 RadarNet 深度神经网络的运行示例

密集占用概率表示

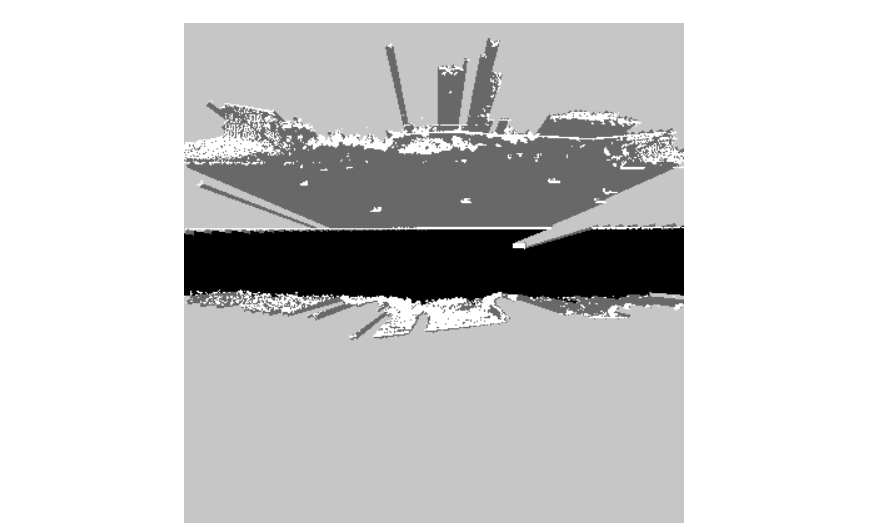

由于雷达检测的稀疏性,传统的雷达感知算法难以单独使用雷达数据对可驱动自由空间进行鲁棒分类。为了克服这一挑战, RadarNet 能够在 2D 鸟瞰图( BEV )中回归密集占用概率图。这种方法受到了 Probably Unknown: Deep Inverse Sensor Modelling Radar 中介绍的工作的启发。

这些标签是通过首先结合现有的人类标记的 3D 障碍物和自由空间标签生成的,然后使用从原始激光雷达点云中得出的观测值进行自动占用计算。从车辆原点到每个障碍物的光线追踪能够推理哪些区域是:

- 观察和自由

- 观察到并占用

- 未观测到的

- 部分观察到

对 DNN 进行训练,以输出以下占用预测:

- 直接观察到并被占用的区域的高概率

- 直接观察到并且没有任何障碍物的区域的低概率

- 对于未观测到的区域,保持明确不确定的中等概率,输出概率( p = 0.5 )

观察到的和被占领的区域可以进一步细分为其他类别,例如动态障碍类别。甚至可以通过激光雷达传感器的后处理信息将区域标记为升高。这导致了具有以下分类的分割图:

- 动态障碍物(车辆、行人)

- 一般非驾驶障碍物(护栏、灌木、灯杆)

- 可行驶障碍物下的一般情况(桥梁、道路上方的树木)

- 未观测到的

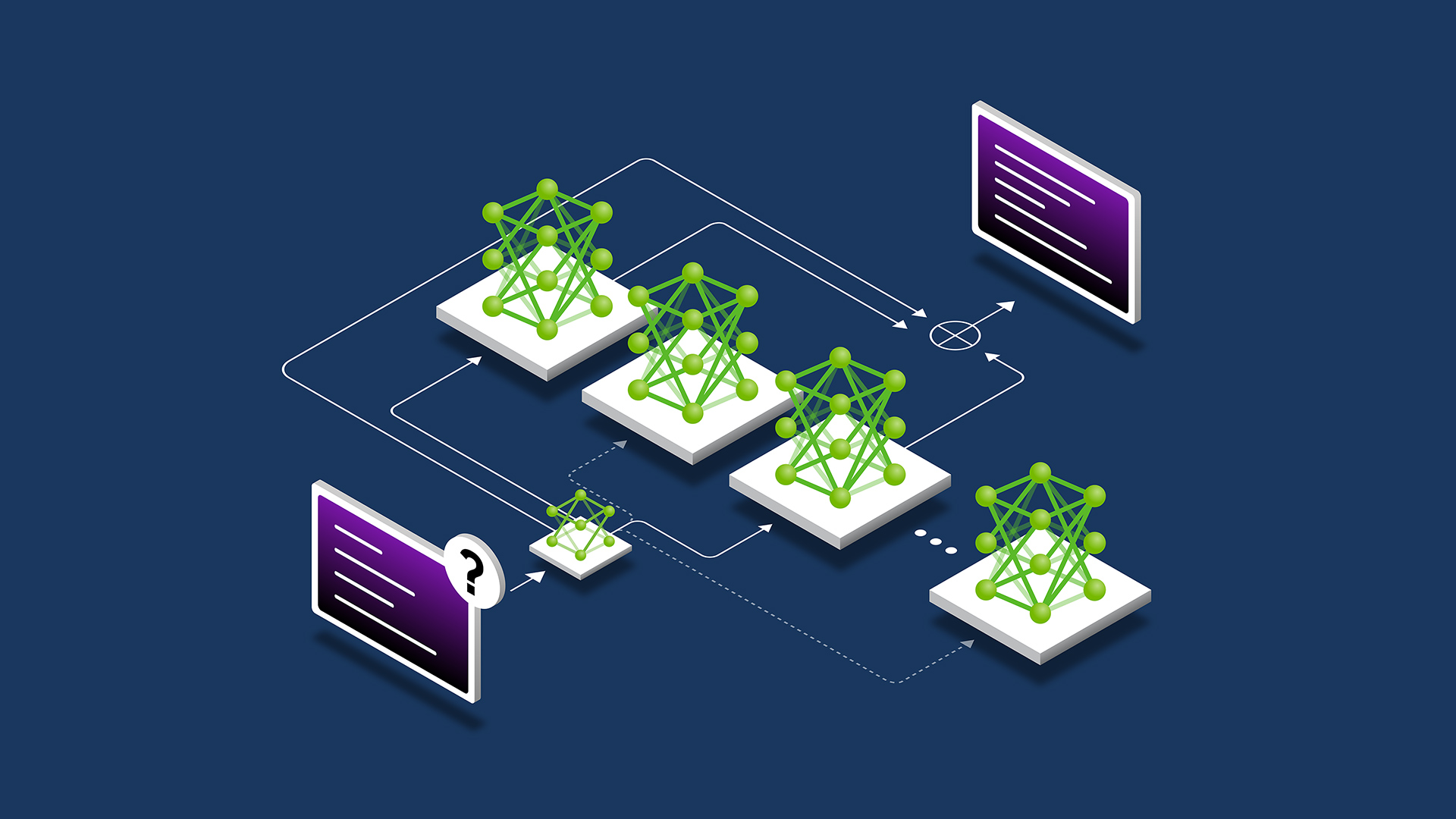

占用概率图与目标检测一起训练,作为 RadarNet DNN 的额外任务负责人。这样做可以保证这些任务之间的一致性,并降低总体计算需求。与原始 RadarNet 相比,总延迟增加不超过 10% 。

可驱动自由空间径向距离图的提取

可以对这种密集占用概率表示进行进一步的后处理,以检测可驱动的自由空间边界。这是通过在所有方位方向上追踪来自车辆原点的光线来完成的,直到占用概率达到某个阈值。

特别地,首先将笛卡尔 BEV 占用概率图重新采样到以车辆原点为中心的极坐标系中。其次,我们在所有角度方向上迭代,将高于所需概率阈值的第一个 bin 标记为该角度的最终边界。通过预先计算笛卡尔到极坐标的重采样网格,然后进行最近邻插值,可以进一步优化这一过程。最终的径向距离图( RDM )输出显示为 ego 车辆周围的一组多段线。

结论

本文中介绍的仅限雷达驱动的自由空间检测器预测了密集的占用概率,可以以显著的精度稳健地检测自由空间边界,同时运行速度足够快,可以轻松地与 NVIDIA DRIVE AGX Orin 上的 NVIDIA AV 堆栈的其余部分放在一起。

目前的雷达网同时支持动态物体检测和可驱动自由空间检测。物体检测被分为多个类别,例如汽车、自行车和行人。占用区域被进一步划分为高架、非高架或未观测区域。然后, RadarNet 的输出被用作具有基于相机的检测器的多传感器融合系统的输入,从而提高 AV 的鲁棒性。

有关更详细的解释,请参见 NVRadarNet: Real-Time Radar Obstacle and Free Space Detection for Autonomous Driving 。要了解有关软件功能的更多信息,请参阅 Perceiving with Confidence: How AI Improves Radar Perception for Autonomous Vehicles from the NVIDIA DRIVE Lab 系列视频和 NVIDIA DRIVE Dispatch 描述 RadarNet 空闲空间的视频。

Register for NVIDIA GTC 2023 for free ,并于 3 月 20-23 日加入我们,了解更多鼓舞人心的内容和相关的专家主导的会议。