在COMPUTEX 2023, NVIDIA 宣布NVIDIA DGX GH200,这标志着 GPU 的又一突破——加速计算,为最苛刻的巨型人工智能工作负载提供动力。除了描述 NVIDIA DGX GH200 体系结构的关键方面外,本文还讨论了如何使用NVIDIA Base Command实现快速部署,加快用户入职,并简化系统管理。

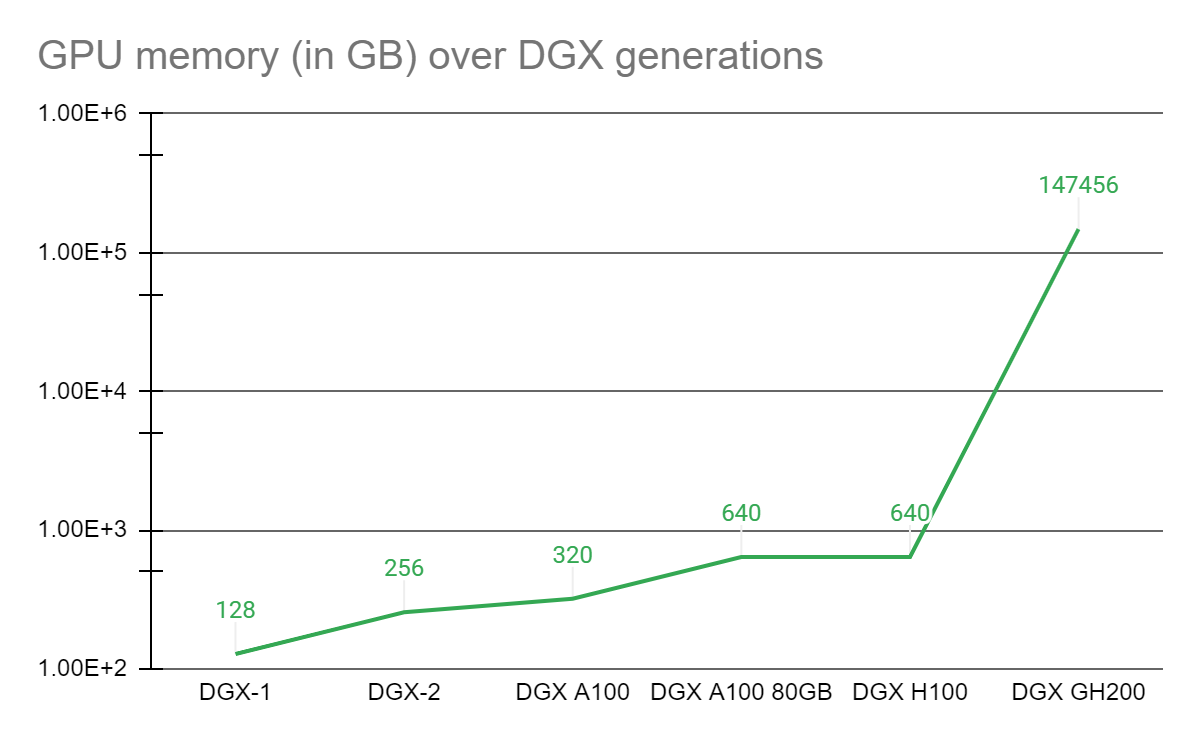

GPU 的统一内存编程模型是过去 7 年来复杂加速计算应用取得各种突破的基石。 2016 年, NVIDIA 推出NVLink技术和带有 CUDA-6 的统一内存编程模型,旨在增加 GPU 加速工作负载的可用内存。

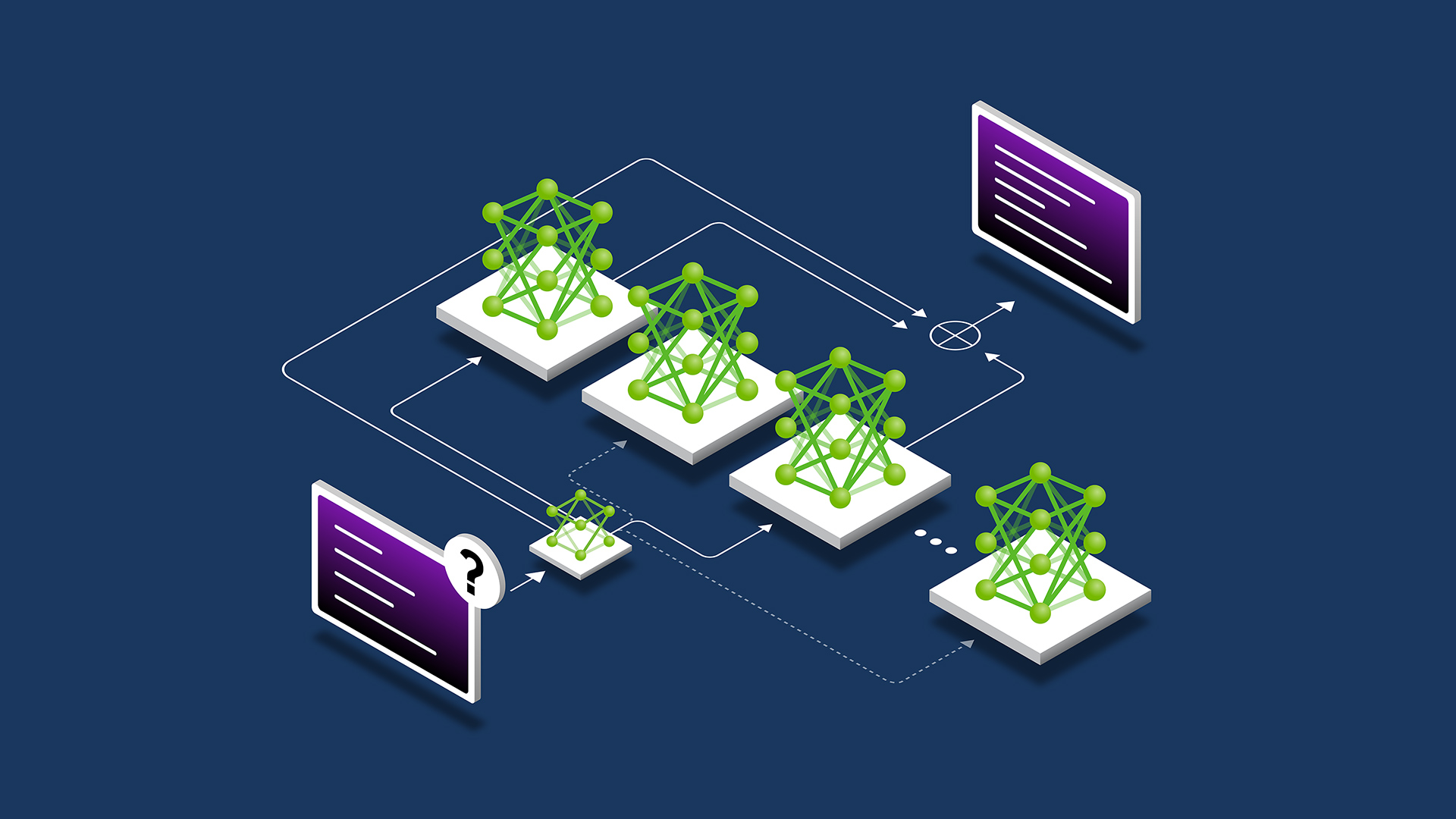

从那时起,每个 DGX 系统的核心都是与 NVLink 互连的基板上的 GPU 复合体,其中每个 GPU 可以以 NVLink 的速度访问另一个的存储器。许多具有 GPU 复合体的 DGX 通过高速网络互连,形成更大的超级计算机,如NVIDIA Selene 超级计算机。然而,一类新兴的万亿参数的巨型人工智能模型要么需要几个月的训练,要么即使在当今最好的超级计算机上也无法求解。

为了让需要一个能够解决这些非凡挑战的先进平台的科学家们获得力量, NVIDIA NVIDIA Grace Hopper Superchip与 NVLink 交换系统,在 NVIDIA DGX GH200 系统中集成多达 256 GPU 。在 DGX GH200 系统中, GPU 共享内存编程模型可以通过 NVLink 高速访问 144 TB 的内存。

与单个相比NVIDIA DGX A100 320 GB 系统, NVIDIA DGX GH200 通过 NVLink 为 GPU 共享内存编程模型提供了近 500 倍的内存,形成了一个巨大的数据中心大小的 GPU 。 NVIDIA DGX GH200 是第一台突破 NVLink 上 GPU 可访问内存 100 TB 障碍的超级计算机。

NVIDIA DGX GH200 系统架构

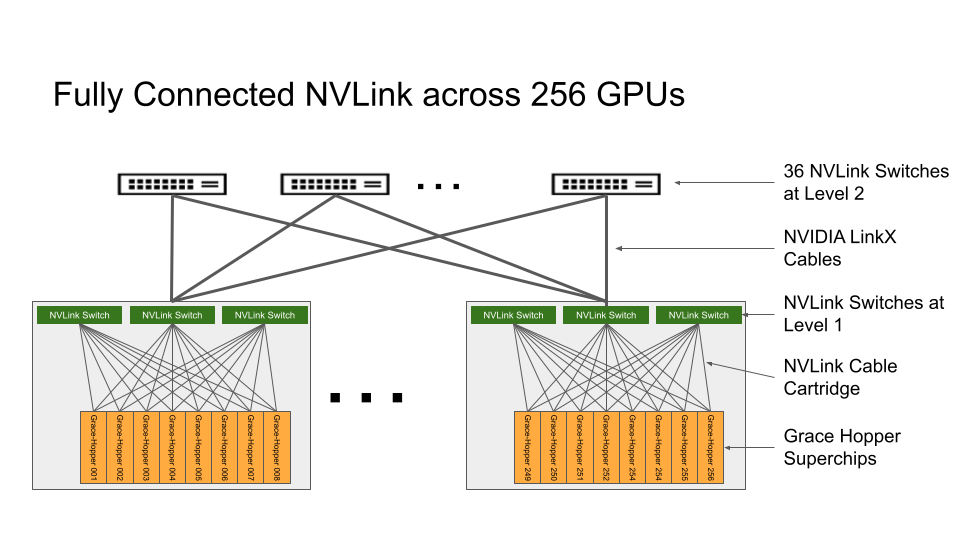

NVIDIA Grace Hopper 超级芯片和 NVLink Switch System 是 NVIDIA DGX GH200 架构的构建块。 NVIDIA Grace Hopper 超级芯片结合了 Grace 和 Hopper 架构,使用 NVIDIA NVLink-C2C以传递 CPU + GPU 相干存储器模型。 NVLink 交换系统由第四代 NVLink 技术提供动力,将 NVLink 连接扩展到超级芯片,以创建无缝、高带宽、多 GPU 系统。

NVIDIA DGX GH200 中的每个 NVIDIA Grace Hopper 超级芯片都有 480 GB LPDDR5 CPU 内存,与 DDR5 和 96 GB 快速 HBM3 相比,每 GB 的功率是其八分之一。 NVIDIA Grace CPU 和 Hopper GPU 与 NVLink-C2C 互连,以五分之一的功率提供比 PCIe Gen5 多 7 倍的带宽。

NVLink 交换系统形成了一个两级、无阻塞、fat-tree NVLink 结构,可在 DGX GH200 系统中完全连接 256 个 Grace Hopper 超级芯片。 DGX GH200 中的每个 GPU 都可以以 900GBps 访问所有 NVIDIA Grace CPU 的其他 GPU 和扩展 GPU 存储器。

托管 Grace Hopper 超级芯片的计算基板使用第一层 NVLink 结构的自定义线束连接到 NVLink 交换机系统。 LinkX 电缆扩展了 NVLink 结构第二层的连接。

在 DGX GH200 系统中, GPU 线程可以使用 NVLink 页表从 NVLink 网络中的其他 Grace Hopper 超级芯片寻址对等 HBM3 和 LPDDR5X 内存。NVIDIA Magnum IO加速库优化了 GPU 通信以提高效率,并通过所有 256 个 GPU 来增强应用程序的可扩展性。

DGX GH200 中的每个 Grace Hopper 超级芯片都配有一个NVIDIA ConnectX-7网络适配器和一个NVIDIA BlueField-3 NICDGX GH200 在网络计算中具有 128 TBps 的双段带宽和 230 . 4 TFLOPS 的 NVIDIA SHARP ,以加速人工智能中常用的集体操作,并通过减少集体操作的通信开销使 NVLink 网络系统的有效带宽翻倍。

对于超过 256 GPU 的扩展, ConnectX-7 适配器可以将多个 DGX GH200 系统互连,以扩展到更大的解决方案中。 BlueField -3 DPU 的强大功能将任何企业计算环境转变为安全且加速的虚拟私有云,使组织能够在安全的多租户环境中运行应用程序工作负载。

目标使用案例和性能优势

GPU 内存的跨代显著提高了受 GPU ‘内存大小限制的 AI 和 HPC 应用程序的性能。许多主流 AI 和 HPC 工作负载可以完全驻留在单个NVIDIA DGX H100对于此类工作负载, DGX H100 是性能效率最高的培训解决方案。

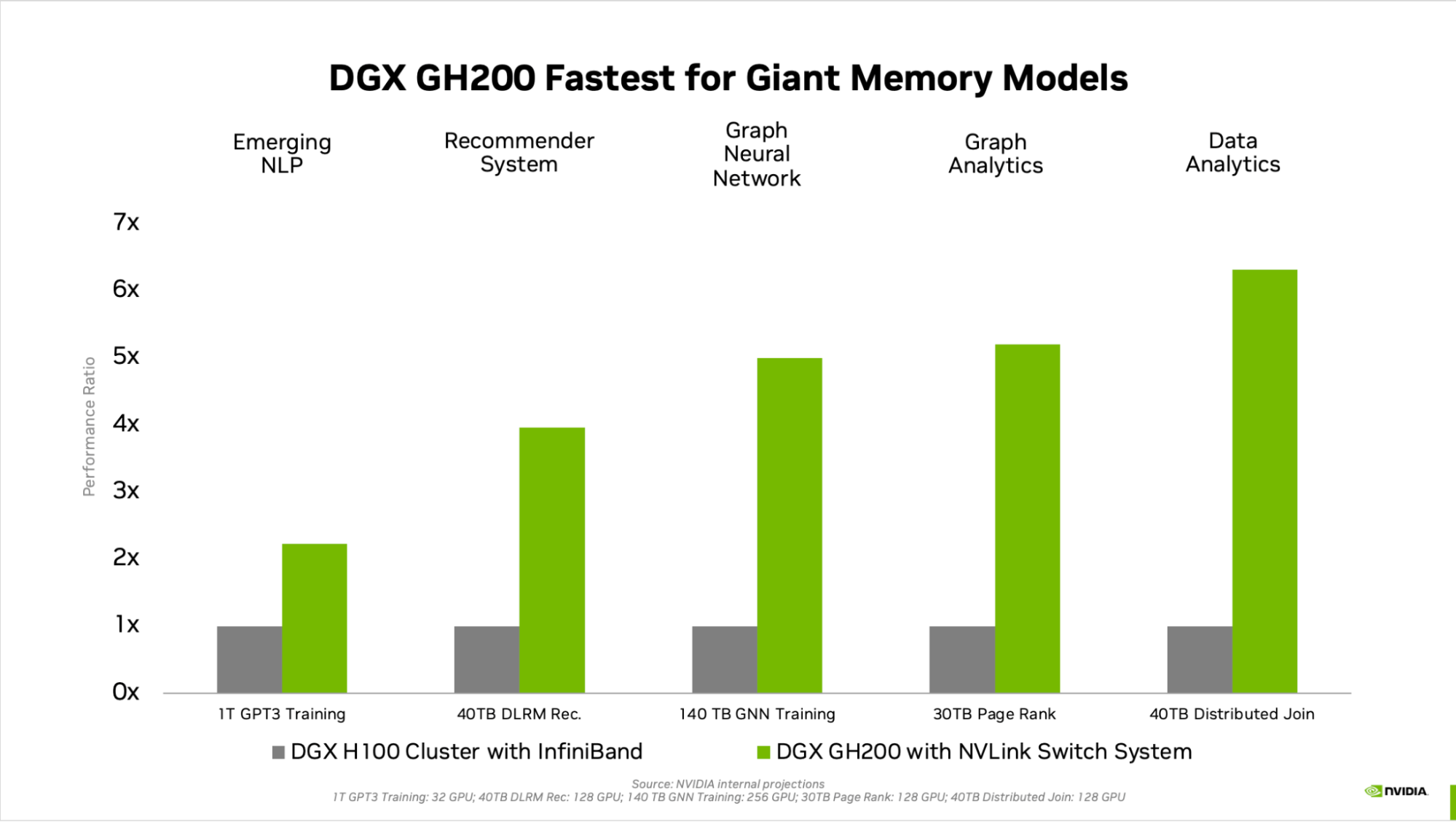

其他工作负载,如具有数 TB 嵌入式表的深度学习推荐模型( DLRM )、数 TB 规模的图形神经网络训练模型或大数据分析工作负载,使用 DGX GH200 可实现 4 到 7 倍的加速。这表明 DGX GH200 是更先进的 AI 和 HPC 模型的更好解决方案,这些模型需要大量内存用于 GPU 共享内存编程。

加速的机制在 NVIDIA Grace Hopper Superchip Architecture白皮书。

专为最苛刻的工作负载而设计

整个 DGX GH200 的每个组件都经过选择,以最大限度地减少瓶颈,同时最大限度地提高关键工作负载的网络性能,并充分利用所有扩展硬件功能。其结果是线性可扩展性和对大量共享内存空间的高利用率。

为了充分利用这一先进系统, NVIDIA 还构建了一个超高速存储结构,以在峰值容量下运行,并处理各种数据类型(文本、表格数据、音频和视频)- 并行且性能稳定。

全栈 NVIDIA 解决方案

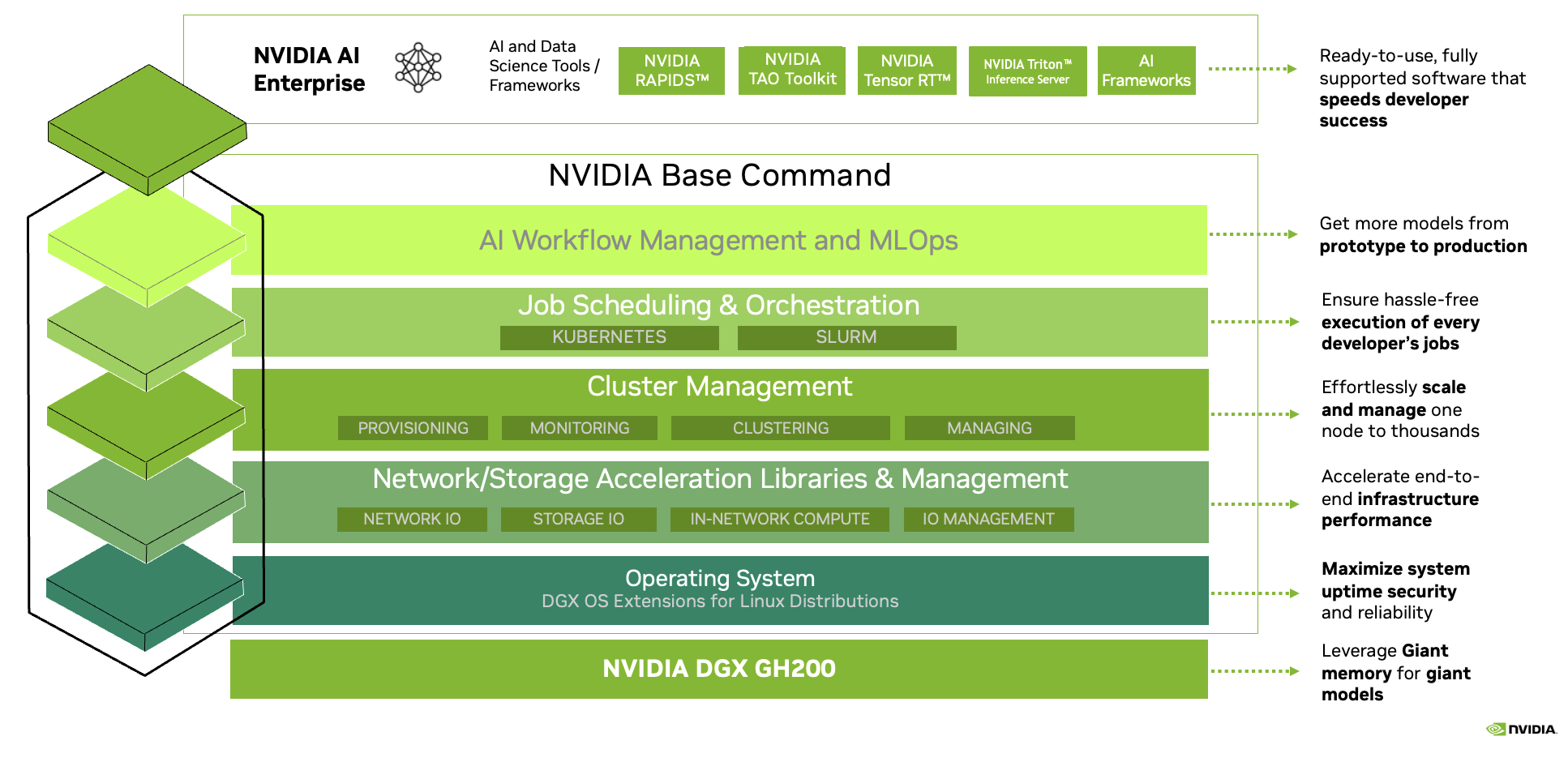

DGX GH200 附带NVIDIA Base Command,包括针对 AI 工作负载优化的操作系统、集群管理器、加速计算、存储的库,以及针对 DGX GH200 系统架构优化的网络基础设施。

DGX GH200 还包括NVIDIA AI 企业版,提供了一套优化的软件和框架,以简化人工智能的开发和部署。此全栈解决方案使客户能够专注于创新,而不用担心管理其 IT 基础架构。

增压巨大的 AI 和 HPC 工作负载

NVIDIA 正致力于在今年年底推出 DGX GH200 。 NVIDIA 渴望提供这台令人难以置信的第一台同类超级计算机,让您能够在解决当今最大的人工智能和 HPC 挑战时进行创新并追求自己的激情。了解更多.