NVIDIA BLUVELD-2 数据处理器( DPU )提供了不匹配的软件定义网络( SDN )性能、可编程性和可扩展性。它集成了八个 Arm CPU 内核、安全的高级 ConnectX-6 Dx 云网络接口和硬件加速器,这些硬件加速器共同卸载、加速和隔离 SDN 功能,执行连接跟踪、流匹配和高级数据包处理。

这篇文章概述了精确 SDN 性能基准的基本原理,并演示了在NVIDIA CONTROX-6DX 上实现的实际结果。 BlueField-2 和下一代 BlueField-3 DPU 包括额外的加速功能,并为更广泛的用例提供更高的性能。

SDN 性能基准最佳实践

BlueField DPU 或 ConnectX SmartNICs 的任何 SDN 性能评估都应充分利用硬件加速器的全部功能。 BLUBELFIED-2 的分组处理动作是通过NVIDIA ASAP 编程的2(加速交换和数据包处理)引擎。 BlueField DPU 和 ConnectX SmartNICs 上的 SDN 加速器都依赖于 ASAP2以及其他可编程硬件加速器,以实现线速率网络性能。

NVIDIA 尽快2支持已集成到上游 Linux 内核和数据平面开发工具包( DPDK )框架中,并可在一系列 Linux 操作系统发行版和云管理平台中随时获得。

从 Linux 内核 5.6 开始,可以使用连接跟踪加速。最佳实践是使用现代企业 Linux 操作系统,例如 Ubuntu 20.04 、 Red Hat enterprise Linux 8.4 等等。这些较新的内核包括对 SDN 的收件箱支持,以及对 ConnectX-6 Dx SmartNICs 和 BlueField-2 DPU 的连接跟踪加速。基于内核过时的 Linux 系统,通过连接跟踪对 SDN 进行基准测试可能会产生误导。

最后,要使任何 SDN 基准有效,它必须代表在现实世界的云数据中心中实现的 SDN 管道,而在现实世界中,数十万个连接是常态。 ConnectX-6 Dx SmartNICs 和 BlueField-2 DPU 都是为超规模环境而设计和部署的,并在云级别提供突破性的网络性能。

加速 SDN 性能

看看NVIDIA CONTROX-6DX 性能。以下基准测试显示了启用连接跟踪硬件加速的 SDN 管道性能的吞吐量和延迟。我们使用与其他报告结果类似的系统设置、测试工具和程序进行测试。我们运行了 Open VSwitch ( OVS ) DPDK ,以便在 ConnectX-6 Dx SmartNIC 上无缝地实现连接跟踪加速。

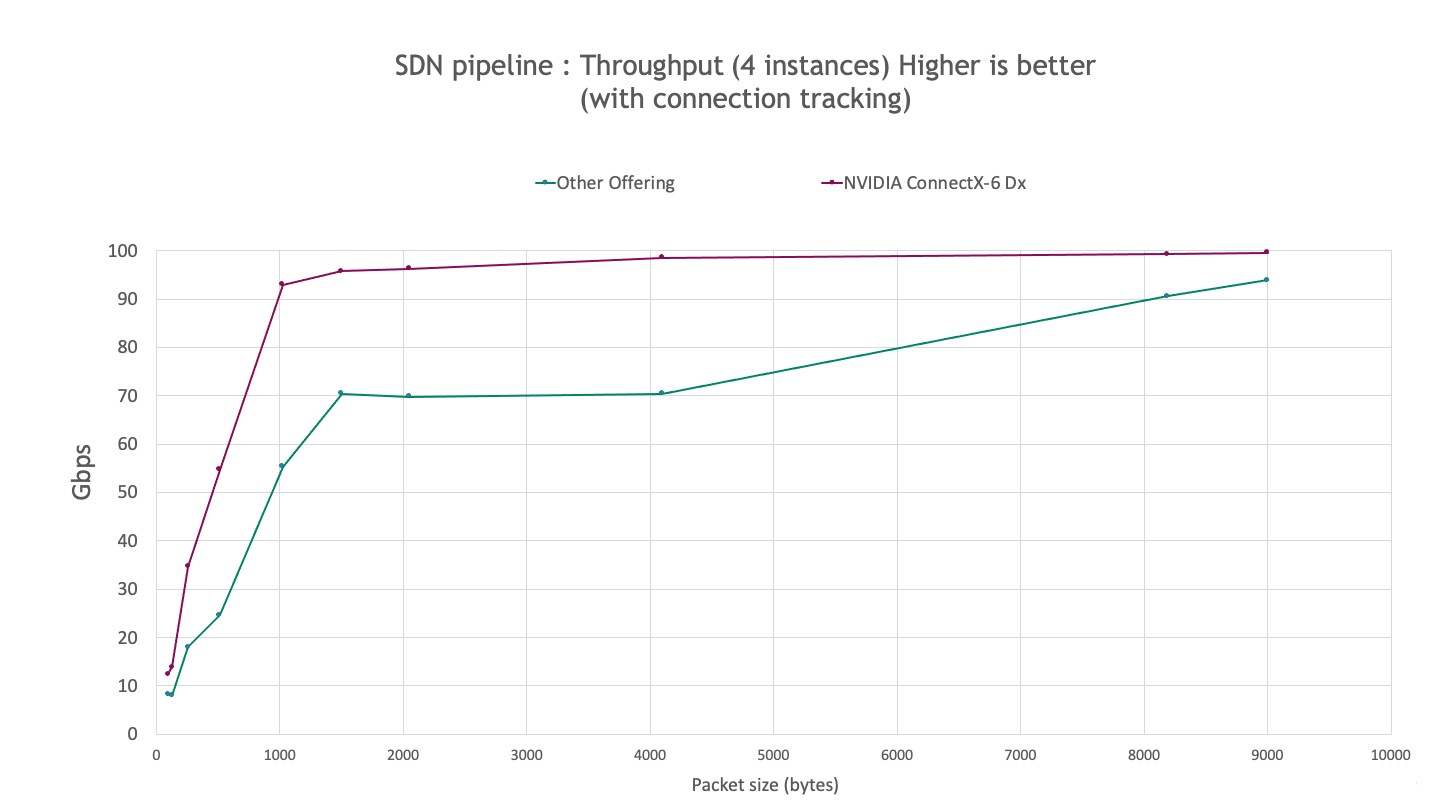

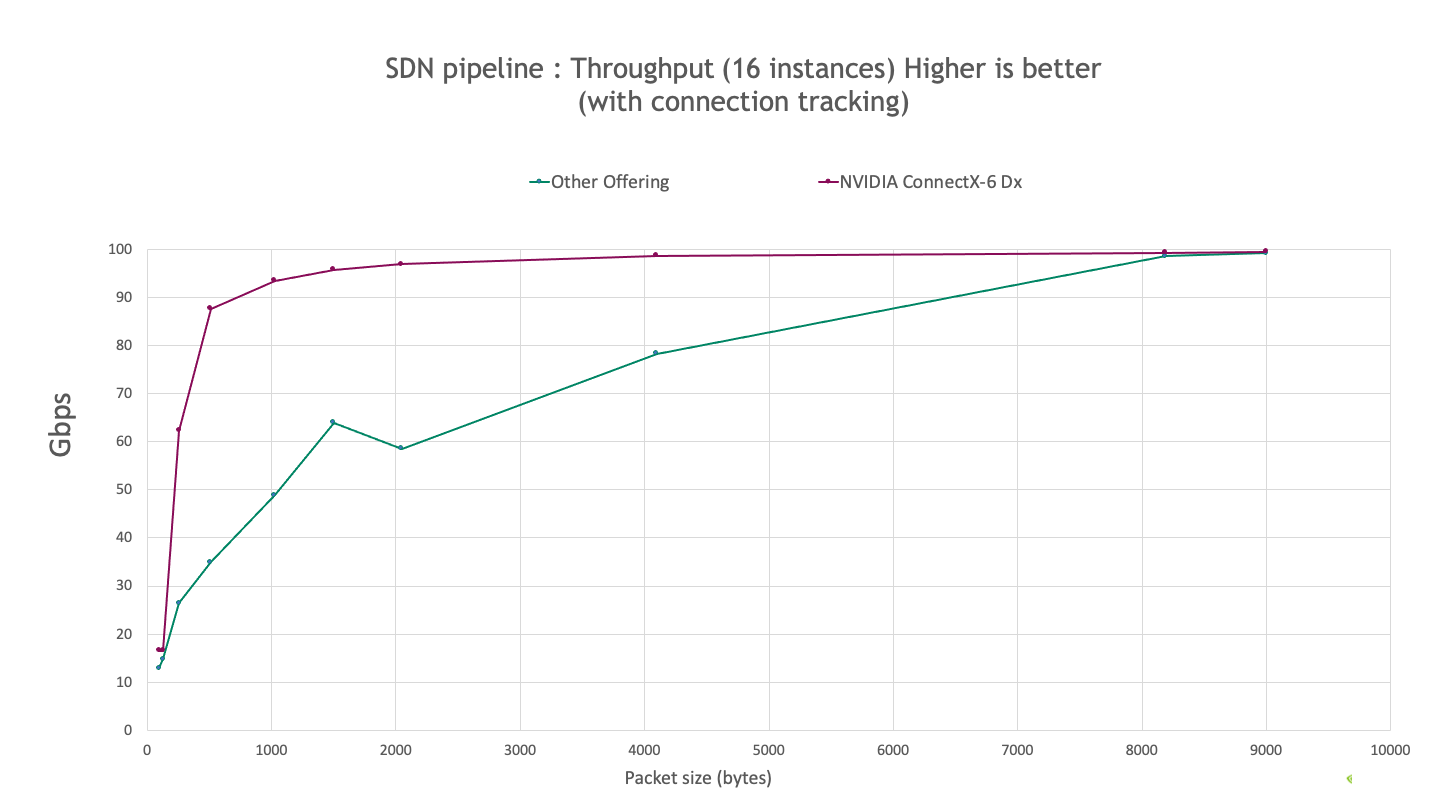

以下图表描述了使用 iperf3 工具对 4 个和 16 个 iperf 实例(每个实例一个流)观察到的 SDN 性能。

主要发现:

- ConnectX-6 Dx 提供了更高的吞吐量,对于所有测试的数据包大小, 4 个和 16 个实例的吞吐量分别高达 120% 和 150% 。

- ConnectX-6 Dx 对于小到 1 KB 的数据包的传输速率大于 90% ,而其他产品的传输速率为 8 KB 。

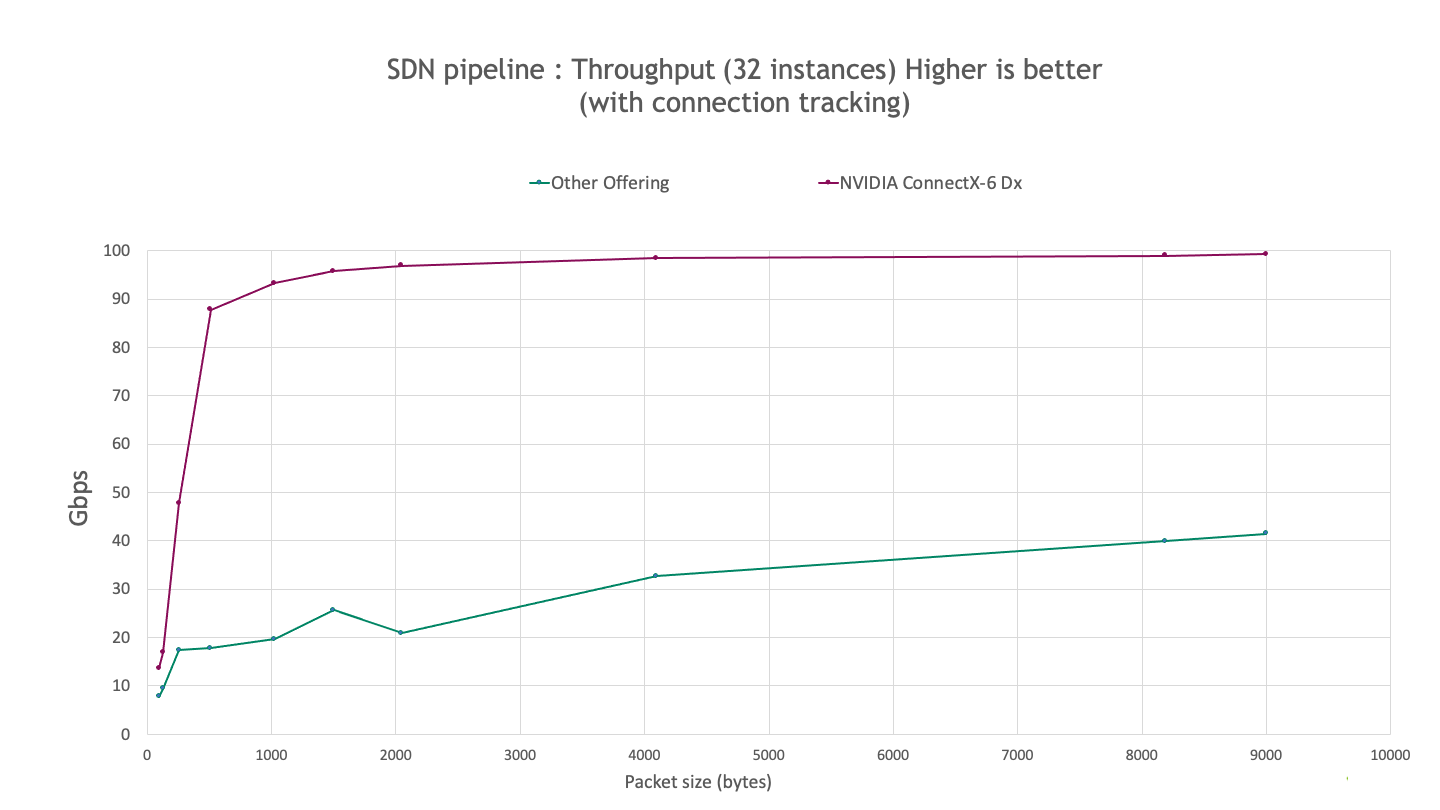

下表显示了在同一系统设置上具有 32 个实例的 SDN 管道的观察性能。结果表明,随着流量的增加, ConnectX-6 Dx 提供了更好的可扩展性,吞吐量提高了 4 倍。

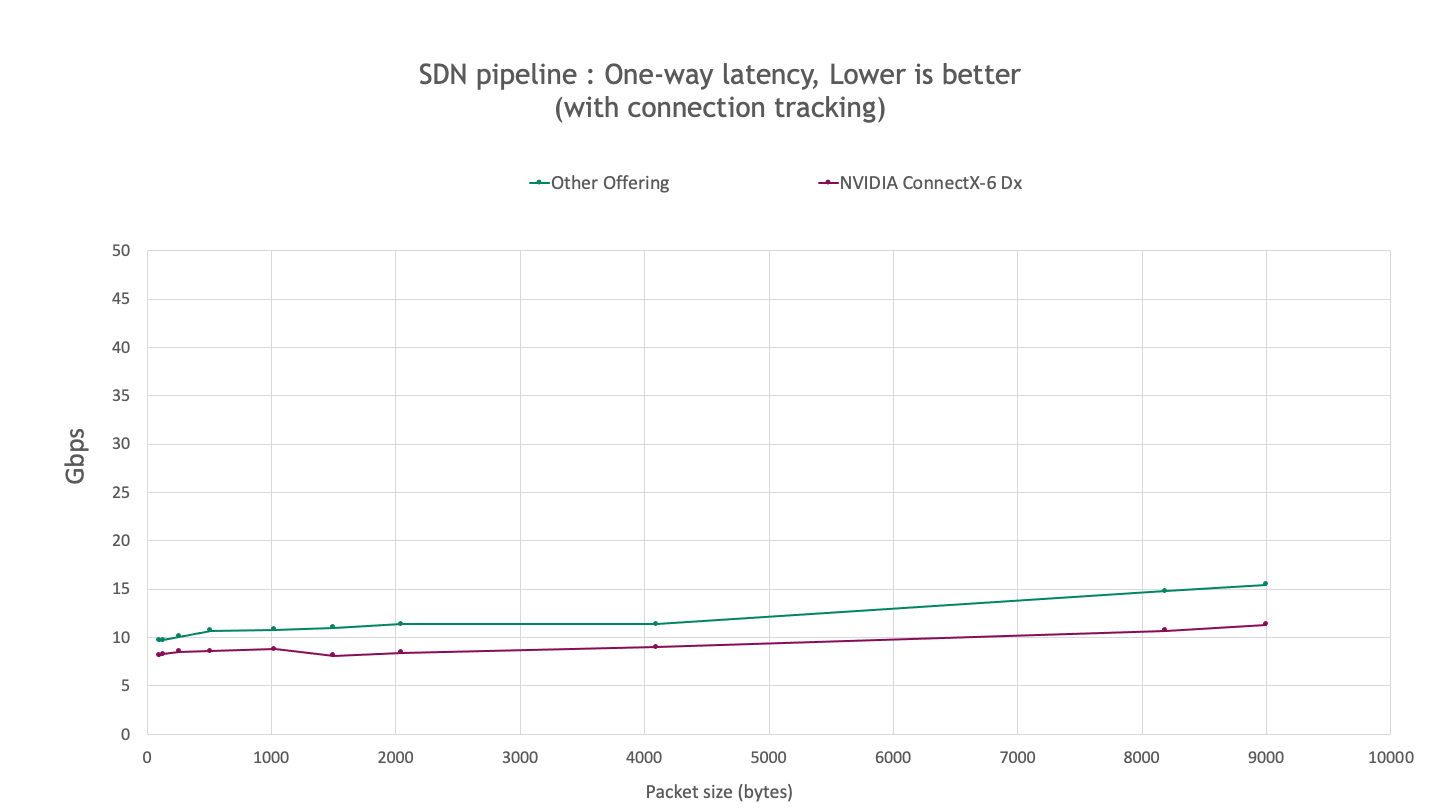

以下基准测试使用 sockperf 测量延迟。结果表明,对于测试的所有数据包大小,与其他产品相比, ConnectX-6 Dx 的延迟降低了约 20-30% 。

非加速连接跟踪实现会在主机 CPU 上造成瓶颈。将连接跟踪转移到片上加速器意味着在这些基准测试中实现的性能并不强烈依赖于主机 CPU 或其驱动测试台的能力。这些结果也表明了集成了 ConnectX-6 Dx 的 BlueField-2 DPU 可实现的性能。

BlueField-3 支持更高的性能级别

NVIDIA 欢迎有机会测试和展示 ConnectX-6 Dx 和 BlueField-2 的性能,同时遵守行业最佳实践和操作标准。本文中显示的数据将 ConnectX-6 Dx 的性能基准测试结果与其他地方报告的结果进行了比较。与其他产品相比, ConnectX-6 Dx 的吞吐量提高了 4 倍,延迟降低了 30% 。这些基准测试结果证明了NVIDIA 在 SDN 加速技术中的领导地位。

BlueField-3 是下一代 NVIDIA DPU ,集成了先进的 ConnectX-7 适配器和其他加速引擎。 BlueField-3 提供 400 Gb / s 的网络、更强大的 Arm CPU 内核和高度可编程的数据路径加速器( DPA ),提供更高级别的性能和可编程性,以解决大规模数据中心中最苛刻的工作负载。使用 DOCA 在 BlueField-2 上构建的现有 DPU 加速 SDN 应用程序将受益于 BlueField-3 带来的性能增强,而无需任何代码更改。

进一步了解如何使用 BlueField DPU .随着 BlueField-3 于 2022 年推出,请继续关注更高的 SDN 性能。